Một trí tuệ nhân tạo đã tạo ra một bản cover chấp nhận được của bài hát Another Brick in the Wall, Part 1 của Pink Floyd bằng cách phân tích hoạt động não được ghi lại trong khi người ta nghe bản gốc. Những kết quả này nâng cao hiểu biết của chúng ta về cách chúng ta nhận thức âm thanh và có thể cải thiện thiết bị cho những người gặp khó khăn trong việc nói.

Robert Knight tại Đại học California, Berkeley và các cộng sự đã nghiên cứu những bản ghi từ các điện cực được cấy ghép vào bề mặt não của 29 người để điều trị động kinh.

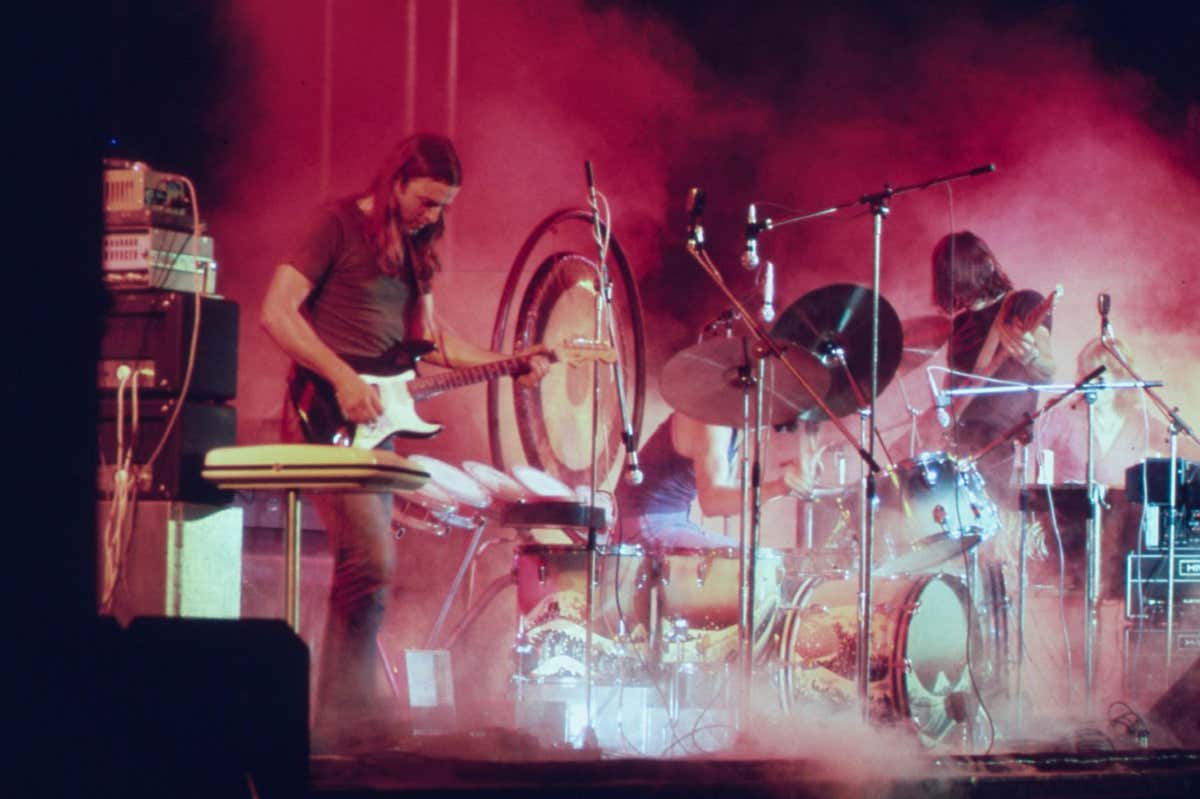

Hoạt động não của người tham gia đã được ghi lại trong khi họ nghe bài hát Another Brick in the Wall, Part 1 của Pink Floyd. Bằng cách so sánh tín hiệu não với bài hát, các nhà nghiên cứu đã xác định được những bản ghi từ một số điện cực liên quan mạnh mẽ đến giai điệu, âm điệu, âm hòa và giai điệu của bài hát.

Sau đó, họ đã đào tạo một trí tuệ nhân tạo để học các liên kết giữa hoạt động não và các yếu tố âm nhạc này, loại trừ một đoạn 15 giây của bài hát khỏi dữ liệu đào tạo. Trí tuệ nhân tạo đã được đào tạo đã tạo ra một dự đoán về đoạn nhạc không nhìn thấy dựa trên tín hiệu não của người tham gia. Phổ màu - một hình ảnh hóa của sóng âm - của đoạn nhạc được tạo ra bởi trí tuệ nhân tạo tương đồng với phổ màu thực tế của đoạn nhạc là 43%.

Đây là đoạn nhạc gốc sau một số xử lý đơn giản để so sánh công bằng với đoạn nhạc được tạo ra bởi trí tuệ nhân tạo, mà hạ chất lượng khi chuyển từ phổ màu thành âm thanh:

Và đây là đoạn nhạc được tạo ra bởi trí tuệ nhân tạo:

Các nhà nghiên cứu đã xác định một khu vực của não trong một khu vực được gọi là vòm tham cao xuất hiện xử lý nhịp điệu của đàn guitar trong bài hát. Họ cũng phát hiện rằng tín hiệu từ bán cầu phải của não quan trọng hơn đối với việc xử lý âm nhạc so với tín hiệu từ bán cầu trái, xác nhận kết quả từ các nghiên cứu trước đó.

Bằng cách sâu rộng hiểu biết của chúng ta về cách não nhận thức âm nhạc, công việc này cuối cùng có thể giúp cải thiện thiết bị nói thay mặt cho những người gặp khó khăn trong việc nói, theo Knight.

"Đối với những người mắc bệnh hạch tạng bên chéo hoặc bệnh loạn ngôn ngữ, gặp khó khăn trong việc nói, chúng tôi muốn có một thiết bị thực sự nghe như bạn đang giao tiếp với ai đó một cách con người," ông nói. "Hiểu cách não biểu thị các yếu tố âm nhạc trong lời nói, bao gồm âm sắc và cảm xúc, có thể làm cho những thiết bị này nghe ít giống như robot hơn."

Tính xâm chiếm của các cấy ghép não khiến khó khả thi việc áp dụng quy trình này cho các ứng dụng không lâm sàng, ông Knight nói. Tuy nhiên, các nhà nghiên cứu khác đã gần đây sử dụng trí tuệ nhân tạo để tạo ra những đoạn nhạc từ tín hiệu não được ghi lại bằng cách sử dụng quét hình từ cộng hưởng từ (MRI).

Nếu trí tuệ nhân tạo có thể sử dụng tín hiệu não để tái hiện âm nhạc mà con người tưởng tượng ra, không chỉ là nghe, phương pháp này có thể được sử dụng để sáng tác âm nhạc, theo Ludovic Bellier tại Đại học California, Berkeley, một thành viên trong nhóm nghiên cứu.

Theo Việc người nghe nhạc sở hữu bản tái tạo còn có thể phụ thuộc vào các khu vực não liên quan, theo Ceyhun Pehlivan, luật sư tại công ty luật Linklaters ở Madrid. "Liệu có khác biệt nào nếu âm thanh xuất phát từ phần não lành mạnh, chẳng hạn như vỏ thính giác, thay vì vỏ trước trách nhiệm cho tư duy sáng tạo? Có lẽ các tòa án sẽ cần xem xét những câu hỏi phức tạp như vậy trên cơ sở từng trường hợp," anh ta nói. PLOS Biology DOI: 10.1371/journal.pbio.3002176 Chủ đề: