Các nhà cung cấp đám mây đang xây dựng đội quân GPU để cung cấp nhiều sức mạnh AI hơn. Tại hội nghị phát triển Google I/O hàng năm của mình hôm nay, Google đã công bố siêu máy tính AI với 26.000 GPU. Siêu máy tính Compute Engine A3 là một điểm chứng khác cho việc Google đang dồn nhiều tài nguyên trong cuộc chiến tranh vì uy tín AI với Microsoft.

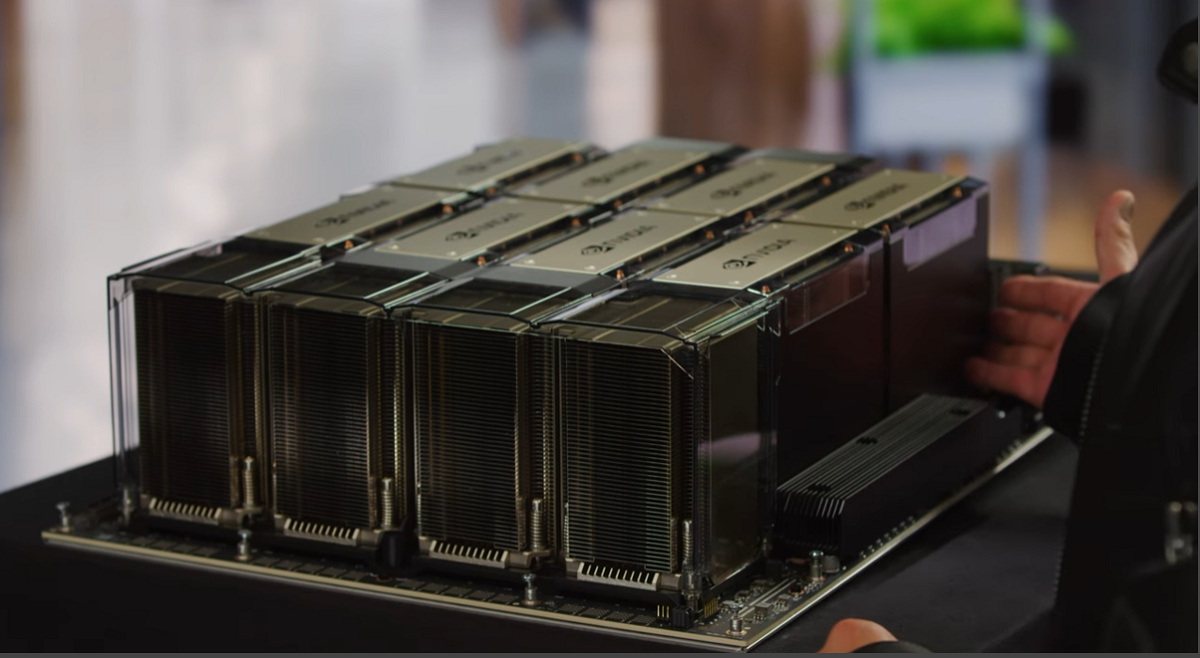

Hệ thống siêu máy tính có khoảng 26.000 GPU Nvidia H100 Hopper. Cho tham chiếu, siêu máy tính công cộng nhanh nhất thế giới, Frontier, có 37.000 GPU AMD Instinct 250X.

"Đối với khách hàng lớn nhất của chúng tôi, chúng tôi có thể xây dựng siêu máy tính A3 lên đến 26.000 GPU trong một cụm đơn và đang làm việc để xây dựng nhiều cụm ở vùng lớn nhất của chúng tôi”, một phát ngôn viên của Google cho biết trong email, bổ sung rằng “không phải tất cả các địa điểm của chúng tôi đều được tăng kích thước lớn như vậy".

Hệ thống này được công bố tại cuộc hội nghị Google I/O, diễn ra tại Mountain View, California. Hội nghị phát triển đã trở thành trưng bày các khả năng phần cứng và mềm của AI của Google. Google đã tăng tốc phát triển AI của mình sau khi Microsoft đưa các công nghệ từ OpenAI vào tìm kiếm Bing và các ứng dụng năng suất văn phòng.

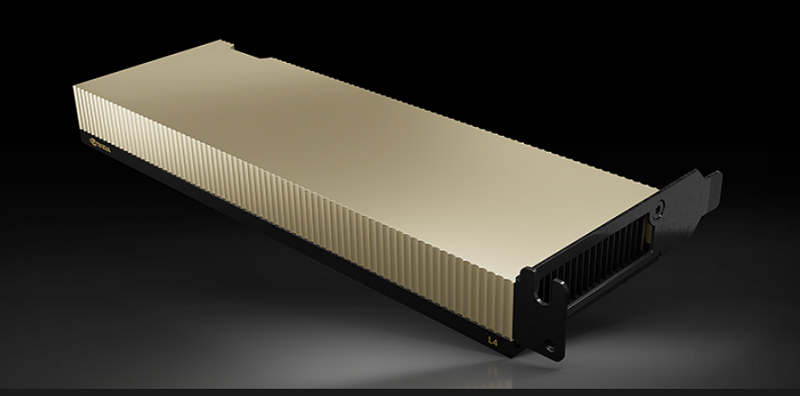

Siêu máy tính này được nhắm đến các khách hàng đang tìm cách đào tạo các mô hình ngôn ngữ lớn. Google công bố các trường hợp sử dụng máy ảo A3 đi kèm cho các công ty đang muốn sử dụng siêu máy tính. Nhiều nhà cung cấp đám mây hiện đang triển khai H100 GPU, và Nvidia vào tháng 3 đã ra mắt dịch vụ đám mây DGX riêng của mình, có giá đắt hơn so với việc thuê A100 GPU thế hệ trước.

Google cho biết siêu máy tính A3 là một nâng cấp đáng kể so với tài nguyên tính toán được cung cấp bởi các máy ảo A2 hiện có với GPU A100 của Nvidia. Google đang gom tất cả các trường hợp tính toán A3, được phân bổ địa lý, vào một siêu máy tính duy nhất.

“Quy mô của siêu máy tính A3 cung cấp tới 26 exaflops năng suất AI, cải thiện đáng kể thời gian và chi phí cho đào tạo các mô hình ML lớn”, Roy Kim của Google, một giám đốc, và Chris Kleban, một quản lý sản phẩm, đã viết trong một bài đăng trên blog.

Thước đo năng suất exaflops, được các công ty sử dụng để ước tính hiệu suất thô của một máy tính AI, vẫn được nhìn nhận với chút nghi ngại bởi những người phê bình. Trong trường hợp của Google, flops được phân bổ trong hiệu suất của Tensor Core TF32 dành cho đào tạo mục tiêu, giúp bạn đạt được “exaflops” khoảng 30 lần nhanh hơn so với toán học dấu phẩy động đôi (FP64) mà phần lớn các ứng dụng HPC truyền thống vẫn yêu cầu.

Số lượng GPU đã trở thành một thẻ gọi khách hàng quan trọng để quảng cáo dịch vụ máy tính AI của các nhà cung cấp đám mây. Siêu máy tính AI trên Azure của Microsoft, được xây dựng phối hợp với OpenAI, có 285.000 lõi CPU và 10.000 GPU. Microsoft cũng đã thông báo về siêu máy tính AI thế hệ tiếp theo của mình với nhiều GPU hơn. Dịch vụ đám mây của Oracle cung cấp truy cập vào các cụm với 512 GPU, và đang làm việc trên công nghệ mới để tăng tốc độ mà GPU giao tiếp.

Google đã nhấn mạnh về chips trí tuệ nhân tạo TPU v4 của mình, đang được sử dụng để chạy các ứng dụng trí tuệ nhân tạo bên trong với các LLM, chẳng hạn như ứng dụng Bard của Google. Công ty con của AI của Google, DeepMind, đã nói rằng các TPUs nhanh đang hướng dẫn phát triển AI cho các ứng dụng chung và khoa học.