1

1

Gần đây, chúng tôi đã nhận được nhiều câu hỏi, liên quan đến AI và Học máy (ML) sẽ ảnh hưởng đến lĩnh vực nào tiếp theo. Đây là câu hỏi hợp lý bởi vì ChatGTP và Stable Diffusion đã có một tác động rất đáng kể. Có thể tập trung vào như thế nào hai công nghệ này sẽ thay đổi quy trình làm việc và công việc của chúng ta, nhưng còn có một cuộc cách mạng khác đang diễn ra với học máy trong việc chụp thể tích. Hoặc nói cách khác là việc ghi lại trải nghiệm để bất kỳ ai xem trực tiếp trên các thiết bị di động tiêu chuẩn. Chào mừng đến với thế giới mới của các " trải nghiệm chuyên nghiệp" và NeRFs.

Những nền tảng về AI

AI hoặc Học máy đã mở ra những khả năng đáng kinh ngạc. NeRFs, bất cứ lúc nào, sẽ chiếm trọn sự chú ý trong cuộc thảo luận về ML nhưng lại bị bỏ qua đôi chút do sự chú ý được dành cho AI trò chuyện và hình ảnh suy luận. Một trường hợp của NeRF là Neural Radiance Field - một mạng thần kinh kết nối đầy đủ được sử dụng để tạo ra các cảnh 3D phức tạp, dựa trên chỉ một tập hợp phần của các hình ảnh 2D (xem câu chuyệnGDC của chúng tôi trước đó ). NeRF lấy các hình ảnh đầu vào biểu thị một cảnh và giữa chúng để tạo ra một cảnh hoàn chỉnh. Theo một chuyên gia nhận xét với chúng tôi: "NeRFs đã thay đổi cách chúng ta từng nghĩ về việc mô hình hóa thế giới, hãy nói là mười năm trước hoặc thậm chí là bốn năm trước, và cách chúng ta nghĩ về nó trong thế giới của các lĩnh vực phát xạ".

Chúng tôi đã yêu cầu mạng Bard AI của Google giải thích về NeRF:

"NeRF, hoặc Neural Radiance Field, là một loại biểu diễn 3D có thể được tạo ra từ một bộ sưu tập các hình ảnh. NeRFs có thể bắt được hình học và diện mạo của một cảnh một cách chi tiết và chân thật hơn các mô hình 3D truyền thống. NeRFs được tạo ra bằng cách sử dụng một mạng nơ-ron được huấn luyện trên một tập hợp các hình ảnh của một cảnh. Mạng nơ-ron học cách liên kết mỗi pixel trong ảnh với một điểm trong không gian 3D. Thông tin này sau đó được sử dụng để tạo ra biểu diễn 3D của cảnh.

NeRFs có một số lợi thế so với các mô hình 3D truyền thống.

• Đầu tiên, chúng có khả năng bắt được nhiều chi tiết hơn. Điều này là do NeRFs có thể sử dụng thông tin từ nhiều hình ảnh để tạo ra một mô hình 3D.

• Thứ hai, NeRFs có khả năng bắt được diện mạo của một cảnh một cách chân thật hơn. Điều này là do NeRFs có thể sử dụng thông tin về màu sắc và kết cấu các đối tượng trong một cảnh để tạo ra một mô hình 3D chân thực hơn."

Bard đã làm tốt công việc tóm tắt. NeRFs không phải là phương pháp chụp ảnh giống photogrammetry, trong ngữ cảnh đúng, nó mạnh mẽ hơn nhiều. NeRF không phải là sự đổi mới duy nhất trong việc Chụp thể tích dựa trên ML, nhưng nó là ví dụ tiêu biểu. Nó sản xuất một chức năng 5D biểu thị bức xạ được phát ra theo tất cả các hướng, tùy thuộc vào đầu ra NeRF mà bạn có thể xem được hình ảnh với các tính chất ánh sáng có thể tin cậy từ một góc nhìn mới, nó có thể "khá giống" là một ước lượng ML nhanh chóng của Light Field. Một trường ánh sáng có thể là một hàm vector chính xác hơn mô tả lượng ánh sáng - theo mỗi hướng tại mọi điểm trong không gian. Không gian tất cả các chùm ánh sáng có bởi hàm bốn chiều, và độ lớn của mỗi chùm ánh sáng được cho bởi bức xạ của nó. Điều này làm cho trường ánh sáng có thể được sử dụng để tạo ra chiếu sáng chân thật khi bạn di chuyển qua một thể tích, nhưng nó lại không bao giờ dễ dàng hoặc nhanh chóng để làm việc.

Khác với cả photogrammetry và chức năng light field plenoptic, NeRF có thể được sử dụng để tạo cảnh quan từ bất kỳ điểm nhìn nào mà ngay cả khi điểm nhìn không được bao phủ bởi bất kỳ hình ảnh đào tạo nào. NeRF đang trở nên nhanh hơn và chính xác hơn với một tốc độ đáng kinh ngạc. Trình kết xuất thể tích cho phép người dùng tạo ra một hình ảnh 2D của một cảnh quan được tổng hợp hoặc bộ dữ liệu 3D được lấy mẫu rời rạc. Đối với một vị trí máy ảnh cụ thể, các thuật toán kết xuất thể tích cung cấp RGBα (các kênh Đỏ, Xanh lá cây, Xanh dương và Alpha) cho mỗi voxel trong không gian qua đó chùm tia từ máy ảnh được đưa vào. Với GPU hiện đại, điều này đang xảy ra với tốc độ đáng kinh ngạc.

Quan trọng không phải là ML hay toán học liên quan đến việc kết xuất thể tích mà là cách mà điều này sẽ tìm đường vào đời sống làm việc chuyên nghiệp của chúng ta. Với nhiều công nghệ mới, sự giới thiệu tại khởi đầu có thể có vẻ đáng kinh ngạc nhưng người ta không thể ngay lập tức nhìn thấy rằng điều đó sẽ thay đổi cấu trúc luồng công việc chuyên nghiệp của chúng ta.

Capture Cá Nhân: Luma AI

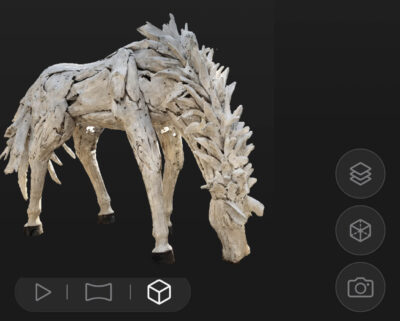

Các chương trình như Luma AI đã cho phép bạn tạo các tệp NeRF của riêng mình và sau đó xuất chúng dưới định dạng khác nhau một cách đơn giản và hiệu quả. Fxguide đã tạo ra NeRF của một tượng ngựa tại Hàn Quốc bằng cách đi bộ quanh nó với một chiếc iPhone sử dụng phiên bản Beta của phần mềm này. Video bên dưới không phải là một điều hành động thực tế của camera, nó là một điều hành camera NeRF xung quanh khối lượng được chụp. Ứng dụng Luma xử lý trên đám mây và tạo ra các hình ảnh trực quan, video và xuất dữ liệu như lưới đối tượng (GLTF hoặc OBJ), đám mây điểm (PLY) hoặc lưới cảnh (PLY).

https://www.fxguide.com/wp-content/uploads/2023/05/korea.mp4 Luma AI hoạt động rất thông minh nhưng đối với các cảnh tĩnh, nó không được thiết kế để chụp động. Những giải pháp và ứng dụng NeRF trong tương lai cần không chỉ chụp lại một cảnh và chụp chuyển động mà cuối cùng còn cho phép tái hiện hoặc cải tiến các câu chuyện mới. Một công ty tiên phong trong nghiên cứu này là Synthesia. “Trò chơi lớn là vượt xa một số diễn xuất cảm nhận và tương tác ánh sáng tĩnh đến động lực của cảnh,” giải thích CTO Jonathan Starck.

Chụp Chuyên Nghiệp

Mục tiêu của Synthesia là làm cho việc sản xuất video dễ dàng cho bất kỳ ai. “Bạn nên có thể điều chỉnh trực tiếp từ ý tưởng đến một video đẹp bằng cách sử dụng văn bản như một đầu vào phổ thông, làm cho nó dễ dàng như việc viết một email,” Jonathan phát biểu. “Điều này sẽ khiến video trở thành công cụ của mọi người.” Với mục đích đó, Synthesia có một đội nghiên cứu lớn 40 người đang tham gia tại Luân Đôn, tập trung vào hai trụ cột chính, “mở khóa nội dung phong phú bằng cách thay thế các máy ảnh vật lý và cho phép tạo ra từ ý tưởng đến video.”Việc đại diện cho hiệu suất của con người bằng tính chính xác cao là rất quan trọng đối với VFX, game và thậm chí là hội nghị truyền hình nâng cao. Tuần này, nhóm nghiên cứu tại Synthesia đã phát hành HumanRF: High-Fidelity Neural Radiance Fields cho Con Người trong Chuyển Động.

HumanRF là một biểu đạt cảnh động 4D dynamic neural đã được chụp lại toàn bộ vẻ ngoài cơ thể trong chuyển động từ nhiều đầu vào video và cho phép phát lại từ bất kỳ góc nhìn không được nhìn thấy nào. Synthesia đã có một doanh nghiệp SaaS lớn trong việc tạo ra các con người số hóa được suy ra từ trình kết xuất neural đã được trì hoãn từ một góc nhìn cụ thể. Con người số hóa của họ đối mặt với máy ảnh và có thể cung cấp bất kỳ đoạn hội thoại nào mà bạn cung cấp dựa trên văn bản hoặc đoạn âm thanh. Với HumanRF, nhóm đã tiến gần hơn tới con người số hóa có thể xem xét việc cung cấp diễn xuất từ bất kỳ góc nhìn nào.

Đó là một nỗ lực lớn để sản xuất “động lực hình ảnh chân thực như ảnh với toàn thân, không chỉ là khuôn mặt,” Jonathan nhận xét. “Đó là tóc, quần áo, tay, vv. và tất cả phải trông thật, tất cả phải có ‘chất lượng sản xuất'”. Mục tiêu của họ là phát lại chất lượng cao với một biểu đạt ngầm. Nhóm không muốn bị ràng buộc bởi việc mô hình hoá các bề mặt rõ ràng cho con người, “các bề mặt rõ ràng sẽ luôn là một xấp xỉ phát sinh vấn đề,” ông thêm. “Chúng tôi đang xây dựng các biểu diễn sử dụng NeRF. Nhiệm vụ của mạng là ‘học’ những gì quan trọng để tái tạo hình ảnh đầu vào chất lượng cao, thay vì yêu cầu một biểu diễn rõ ràng của cảnh được mô hình bởi một người.” Phương pháp HumanRF không sử dụng 3D truyền thống, nó miễn phí mẫu. Nó không sử dụng một biểu diễn trước như SMPL (một hình mẫu cơ thể dưới lớp quần áo). “Chúng tôi cần tự do biểu diễn đa dạng về quần áo/tóc/động lực cho người.” HumanRF về cơ bản là một bộ codec ‘video’ 3D chất lượng cao rất cao. Họ làm điều này bằng cách có NeRF hiệu quả cho phép ‘mô hình’ con người trong chuyển động bằng cách sử dụng mạng neural. “Chúng tôi mã hóa các đoạn thời gian một cách khoa học.” ông giải thích. “Chúng tôi mở rộng phân tích ứng dụng thể tích của các khối thời gian. Đó là một quá trình phân tích 4D với tính liên tục qua các khối thời gian.”

Nhóm phát triển phía sau bao gồm nhà nghiên cứu tài ba Matthias Nießner, người tập trung vào việc tái tạo 3D. Ông ta nổi tiếng với công việc về tái tạo khuôn mặt. Cùng với đồng nghiệp, ông ta đã phát triển Face2Face, là công việc đầu tiên thao tác các biểu hiện trên khuôn mặt từ máy ảnh tiêu dùng trong thời gian thực, sau đó là cơ sở của Synthesia (xem bài viết của chúng tôi năm 2018). Tác giả bài báo mới cũng bao gồm Jonathan Starck, người đọc fxguide có thể biết từ thời gian làm CTO của The Foundry ở Vương quốc Anh. Nghiên cứu do Mustafa Işık, Kỹ sư Nghiên cứu tại Synthesia Lab, người trước đây đã làm việc tại AdobeResearch, cùng với Martin Rünz, Nhà nghiên cứu Nghiên cứu Synthesia cùng với Markos Georgopoulos, Taras Khakhulin và Lourdes Agapito, hoàn thành đội nghiên cứu.

Nghiên cứu mới của họ hoạt động như một bộ mã hóa video động, cho phép tái tạo chi tiết tinh sảo ở tốc độ nén cao. Họ làm điều này thông qua một loạt các bước đổi mới, phân giải không gian-thời gian thành một phân tích ma trận-vector thời gian. Điều này cho phép họ có được các tái tạo mượt (đồng tần xuất thời gian) của các diễn viên cho các chuỗi dài đồng thời đại diện cho các chi tiết độ phân giải cao ngay cả với các chuyển động phức tạp đáng kinh ngạc.

Để tạo ra công trình HumanRF, nhóm Synthesia đã hợp tác với Lee Perry-Smith và nhóm InfiniteRealities, người đã thiết kế và xây dựng hệ thống quét phim mời và chuyển động từ năm 2009. Cùng nhau, họ đã ghi lại cảnh quay 12MP từ 160 camera và 400 LED đa sáng khác nhau của 16 diễn viên theo chuỗi có độ chính xác cao, xác định lại từng khung hình.

Tuần này, nhóm phát hành bài báo về HumanRF và ActorHQ, một tập dữ liệu bao gồm 12 Megapixel/16 chuỗi của 8 người. Tập dữ liệu này được mở mã nguồn cho cộng đồng học thuật. "Đây là một tập dữ liệu duy nhất và chúng tôi hy vọng nó sẽ tiếp thêm động lực cho nghiên cứu các kiểu biểu diễn chất lượng cao mà một ngày nào đó có thể được sử dụng trong sản xuất", Jonathan giải thích. "Hiện tại, chúng tôi đang xây dựng studio đa camera riêng của mình với Esper và IOI để ghi lại các diễn viên nơ-ron chất lượng cao." Studio mới tại Synthesia sẽ nâng cao độ phân giải với việc sử dụng camera 24 Megapixel mới và sẽ được sử dụng không chỉ để ghi lại nhiều phần trình diễn hơn mà còn tạo ra dữ liệu đào tạo máy học chất lượng cao sẽ cho phép Synthesia trở thành khả năng cuối cùng để chỉ đạo và điều khiển các con người số cấp cao với HumanRF mà có thể xem chúng từ bất kỳ góc độ nào.

Đối với một người đơn trong studio, bạn có thể ghi lại rất nhiều dữ liệu để đạt được một người biểu diễn hợp lí có thể thực hiện các hành động và động lực khác nhau. Nhưng như Jonathan giải thích, "nếu bạn muốn tổng quát hóa nó, ví dụ như chúng tôi có thể tạo ra hình ảnh Avatar 3D của bạn chỉ từ một hình ảnh hoặc một chuỗi video ngắn hoặc dữ liệu đơn mắt - thì điều đó đòi hỏi tập dữ liệu lớn - bởi vì nó cần một mô hình tổng quát đầy đủ."

Nên lưu ý rằng hầu hết các phương pháp tiếp cận và tập dữ liệu trước đó đã ở độ phân giải 4MP hoặc thấp hơn, và thường rất hạn chế về quần áo hoặc phạm vi chuyển động. Bộ ActorHQ đại diện cho sự đa dạng không chỉ trong các diễn viên mà còn trong phạm vi các loại quần áo, kiểu tóc và hoạt động của cơ thể/cơ bắp của họ. "Chúng tôi đang phát hành bộ dữ liệu này và tổ chức một hội thảo tại CVPR năm nay để chính thức mở tập dữ liệu cho cộng đồng học thuật", Jonathan chú thích với mục tiêu thúc đẩy "việc tổng hợp chất lượng cao và tổng hợp kiểu dáng mới chất lượng cao".

INSTA: Avatar Đầu Volumetric Nhanh Chóng

Ai đó có thể cho rằng dynamic NeRFs chỉ dành cho các ứng dụng cao cấp liên quan đến 120 máy ảnh và vì vậy cách xa tầm với của phần lớn cá nhân, tuy nhiên, trong thời gian gần đây, INSTA đã được phát hành bởi một nhóm riêng nhưng là đồng nghiệp đáng kính tại Viện Hàn lâm Max Planck về Hệ thống thông minh ở Đức. INSTA cho phép bạn tạo hoặc tái tạo một NeRF có thể hoạt hình của đầu của bạn như một avatar cá nhân - chỉ trong vài phút.

Công việc này do Wojciech Zielonka dẫn đầu, với Timo Bolkart và Justus Thies làm tác giả đồng tác giả. Từ năm 2015, chúng tôi đã báo cáo về công việc nghiên cứu đáng chú ý của Justus Thies (từ khi ông là sinh viên năm thứ hai của tiến sĩ), Giờ đây, ông ta là Nhà lãnh đạo nhóm nghiên cứu Planck tập trung vào việc bắt chước và tổng hợp chuyển động của con người số dựa trên trí tuệ nhân tạo. Công việc mới này có vẻ bắt chước các chuyển động và biểu cảm khuôn mặt của những người có thể ở trong một cuộc họp trực tuyến. "

Để tạo những avatar này - thay vì sử dụng các rig phức tạp và hàng trăm camera, công việc này tái tạo avatar của chủ đề với INSTA trong vài phút (~ 10 phút) và sau đó có thể được sử dụng trong thời gian thực (tốc độ khung hình tương tác). Công nghệ này chỉ sử dụng phần cứng thông dụng để huấn luyện và chụp avatar, chỉ cần một camera RGB duy nhất để ghi lại video đầu vào. Các phương pháp tiên tiến khác sử dụng dữ liệu đầu vào tương tự để tái tạo một avatar con người có thể mất rất nhiều thời gian để huấn luyện, dao động từ khoảng một ngày đến gần một tuần. Hệ thống có thể tạo ra một avatar với một máy ảnh DSLR hoặc thậm chí từ video Youtube.

Một lần nữa, hệ thống có thể cho phép bạn nhìn xung quanh bên cạnh khuôn mặt nếu đầu quay, ngay cả khi diễn viên nguồn được quay từ mặt trước, nhưng quan trọng nhất là khuôn mặt kết quả có thể được thực hiện đáp ứng thời gian thực.

Vậy điều gì sẽ xảy ra?

Trên đây là tất cả những sự thật từ các nguồn chuyên nghiệp hoặc học thuật được đánh giá của đồng nghiệp, nhưng để trả lời câu hỏi ban đầu của chúng tôi về điều này sẽ đi đến đâu, chúng ta cần phỏng đoán. Nói cách khác, những gì sẽ xảy ra sau đó không dựa trên kiến thức bên trong, vi phạm NDA hoặc rò rỉ: đó chỉ là phỏng đoán.

Tại sao thế giới ảo lại tồi tệ như mô hình và đồng thời Apple có thể làm gì?

Một công ty trải nghiệm khách hàng như APPLE có thể làm gì với NeRFs hoặc một phiên bản của nó?

Ned Segal mới đây đã đồn đại rằng Apple đã hoãn kính Apple được đồn đại nhiều lần. Các kính VR trong khi được cải tiến, nhưng chúng xem ra chưa đủ quan trọng và phổ biến trong các thiết bị truyền thông và giải trí (M&E). Bên ngoài một số trò chơi và một số ứng dụng doanh nghiệp, kính VR không phổ biến. Cũng như chúng ta sẽ tranh cãi rằng sự miêu tả phổ biến về một 'Thế giới ảo' là hoàn toàn không có tính thực tế. Hy vọng là thông tin sai lệch, nhưng ý tưởng về việc đeo kính VR và chơi poker với một bữa tiệc đông đảo thường xuyên thì cũng thật buồn cười. Có lẽ một lần như một thủ thuật, nhưng không phải là một mẫu giải trí rộng lớn định kỳ.

Con người thường suy nghĩ công nghệ và giả định một phiên bản mới của một số thực hành hiện tại, vì vậy Internet sẽ rất tuyệt vời cho các công ty xuất bản danh mục kỹ thuật số của họ. Trong khi thực tế là thành công đáng kinh ngạc của Facebook và Youtube cung cấp một nền tảng cho chúng ta để đăng tải những thứ của chúng ta. Mọi người tiên đoán rằng máy tính gia đình sẽ khiến cuộc sống của chúng ta trở nên không cần giấy báo, nhưng thay vào đó, nó dẫn đến một sự bùng nổ của máy in laser. Lịch sử của công nghệ đã chất đống với những suy luận tồi tệ nhưng thực tế là rằng đó là những ứng dụng mới mà thúc đẩy công nghệ vượt trội - không phải các ứng dụng cũ được thực hiện tốt hơn một chút. iPhone đã trở nên phổ biến không phải vì nó cung cấp trải nghiệm cuộc gọi điện thoại mới đáng kinh ngạc. Nó cung cấp truy cập internet di động và khả năng tạo ứng dụng máy tính di động chuyên nghiệp. Bạn có thể thậm chí cãi rằng thêm một máy ảnh từ tính tính toán cho các ứng dụng 'không phải điện thoại' đã dẫn đến một phần lớn thành công của iPhone.

Tránh xa sự họp hyped, chúng ta không phải là tất cả các trang phục NeRF cbyerpunk! (Hình ảnh được tạo ra bởi AI)Toàn bộ những điều này là một cách dài để nói rằng các giải pháp ML thể tích có thể hữu ích cho một số quy trình hiện có, nhưng nó sẽ bùng nổ khi được sử dụng cho các cách mới. Kính VR tốn kém, thiếu tiện nghi và chúng gây cô lập. VR hoặc XR có thể sử dụng công nghệ mới này nhưng điều đó không thay đổi nhiều. Mọi người không sống trong thế giới VR được miêu tả trong Ready Player One (mặc dù chúng ta yêu thích cuốn sách và bộ phim đó). Trong khi Apple được giới đồn đoán đang dừng lại trên nghiên cứu và phát triển của kính hiển vi, thì lại được giới đồn đoán rằng họ đang tiếp tục làm việc trên một thiết bị chụp nhiều hình ảnh. Thực tế, họ được cho là đã có nhiều phiên bản của một thiết bị chụp và nhiều năm nghiên cứu và phát triển để sản phẩm hóa nó vào sinh thái của Apple.

Thiết bị chụp nhiều hình ảnh của Apple.

Điều hợp lý cho Apple là sản xuất một thiết bị ghi hình đa cảm biến mạnh mẽ để bắt thực tại và cho phép người dùng chỉnh sửa theo hình thể không phải để sử dụng cho kính thực tế ảo hay mở rộng thực tế mà cho người dùng iPhone và iPad hàng ngày. Phần mềm FCP video mới nhất hoạt động tuyệt vời trên iPad. Các laptop Macbook Pro mới nhất có thể xử lý 10 luồng video ProRes 422 ở độ phân giải 8192 × 4320 (8K) và 30 khung hình mỗi giây (!). Điều này chỉ áp dụng trên laptop Apple, dẫn đến câu hỏi: chúng ta có thể cần làm gì trên thế hệ tiếp theo của máy tính để bàn Mac Pro để hợp lý cho việc mua nó? Đáp án: chỉnh sửa hình học.

Kinh nghiệm

Với sự dân chủ hóa của sản xuất video, thị trường video doanh nghiệp không còn tồn tại, nhưng có thể có một thị trường trải nghiệm Pro to lớn hoặc 'kinh nghiệm'. Điều này sẽ tồn tại để cung cấp những trải nghiệm động không phải là video tuyến tính. Người sử dụng cuối không sẽ ẩn mình trong đồ chơi VR của họ, nhưng chỉ xem câu chuyện trên thiết bị di động của họ. Nếu ai đó đứng trước tầm nhìn của bạn, hãy kéo thả sang vị trí mới hoặc chỉ cần di chuyển iPhone thực tế của bạn và máy ảnh ảo sẽ xoay sang một bên. Điều này rất hợp lý cho sự bùng nổ của nội dung mới. Mọi người đã có iPhone và iPad, vì vậy tạo nội dung mới cho họ là một mô hình tốt hơn là cố gắng bán kính VR hoặc đồ chơi đầu.

Rất nhiều người sử dụng màn hình thứ hai khi xem cái gì đó trên TV phẳng khổng lồ của họ. Hãy tưởng tượng bạn đang xem trận đấu cuối cùng của môn thể thao yêu thích của bạn, nhưng tập trung vào đầu kia của sân - chỉ cần quay quanh và bạn có thể nhìn qua đầu kia sân khác. Hãy tưởng tượng buổi hòa nhạc yêu thích của bạn, tại sao không xem nó từ bất kỳ góc độ nào? Nhưng điều quan trọng nhất là tưởng tượng khả năng tạo ra một trải nghiệm về cách tạo hoặc sửa chữa cái gì đó - một trải nghiệm NeRF trên YouTube. Bây giờ người dùng cuối có thể phóng to hoặc xem từ bất kỳ góc độ nào để xem những gì bạn đang giải thích. Trong khi bất kỳ thông tin đoạn bắt đầu từ Apple nào cũng không thể giải quyết được những vấn đề cụ thể này ban đầu, thị trường trải nghiệm khách hàng hình học, thậm chí là các trải nghiệm tĩnh sẽ là một thị trường lớn.

Chìa khóa không phải bán nhiều đồ chơi đầu mới cho đại chúng rộng lớn. Người dân muốn tiện lợi, và họ đã có thiết bị di động. Chìa khóa là xây dựng các công cụ thu thập dữ liệu và chỉnh sửa hình học phong phú cho phép chuyên gia và bán chuyên đầu tư vào các thiết bị và quy trình cho phép họ tạo ra những trải nghiệm mới này cho bất kỳ ai để tiêu thụ.

Thế hệ tiếp theo của Mac Pro có thể cần gì? Trình chỉnh sửa NeRF và trí tuệ nhân tạo phức tạp? Dù cho Apple sẽ tung ra một cái gì đó như vậy tại WWDC vào tháng sau hay không, ý tưởng này, hoặc điều gì đó tương tự, là một ứng dụng 'tuyệt vời'. Nếu nó được tung ra, thì chìa khóa là nhìn xa hơn điều này như một cách để chỉ làm một bộ phim nhưng với một số tính năng mới và thay vào đó hiểu rằng nó sẽ có khả năng là một ứng dụng mới hoàn toàn đưa ra làn sóng công nghệ tiếp theo này.