Hồi tháng 2, khi CEO của Meta Mark Zuckerberg tuyên bố rằng công ty đang làm việc trên một loạt các sáng kiến trí tuệ nhân tạo mới, ông đã lưu ý rằng trong số những dự án đó, Meta đang phát triển những trải nghiệm mới với văn bản, hình ảnh, cũng như với video và các yếu tố 'đa phương thức'.

Vậy 'đa phương thức' có nghĩa là gì trong ngữ cảnh này?

Hiện nay, Meta đã trình bày cách AI đa phương thức của mình có thể hoạt động, với việc ra mắt ImageBind, một quy trình cho phép hệ thống trí tuệ nhân tạo hiểu được nhiều đầu vào để đưa ra các đề xuất chính xác và nhạy bén hơn.

Như được giải thích bởi Meta: "Khi con người tiếp thu thông tin từ thế giới, chúng ta tự nhiên sử dụng nhiều giác quan, chẳng hạn như nhìn thấy một con phố đông đúc và nghe những âm thanh của động cơ xe. Hiện nay, chúng tôi giới thiệu một phương pháp mang máy móc gần hơn một bước đến khả năng học tập đồng thời, toàn diện và trực tiếp từ nhiều hình thức thông tin khác nhau - mà không cần sự giám sát rõ ràng. ImageBind là mô hình AI đầu tiên có khả năng liên kết thông tin từ sáu phương thức."

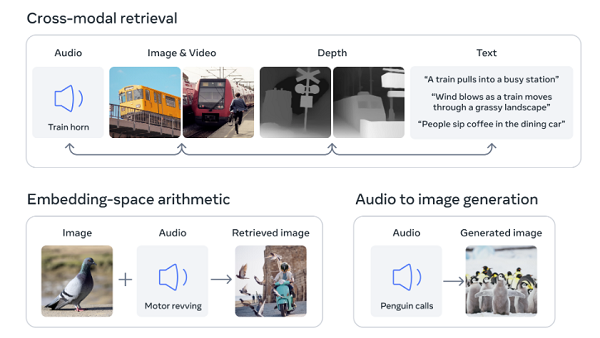

Quá trình ImageBind cho phép hệ thống học tập liên kết, không chỉ giữa văn bản, hình ảnh và video mà còn âm thanh, độ sâu (qua cảm biến 3D), và ngay cả đầu vào nhiệt. Kết hợp với nhau, các yếu tố này có thể cung cấp dấu vết khí quyển chính xác hơn, từ đó cho phép hệ thống tạo ra các đại diện và liên kết chính xác hơn, mang trải nghiệm trí tuệ nhân tạo một bước gần hơn đến các phản ứng con người.

"Theo ví dụ, sử dụng ImageBind, Make-A-Scene của Meta có thể tạo ra hình ảnh từ âm thanh, chẳng hạn như tạo ra hình ảnh dựa trên âm thanh của một rừng mưa hoặc một chợ đông đúc. Các khả năng khác trong tương lai bao gồm cách nhận diện, kết nối và điều chỉnh nội dung chính xác hơn, và tăng cường thiết kế sáng tạo, chẳng hạn như tạo ra phương tiện phong phú hơn một cách mượt mà hơn và tạo ra các chức năng tìm kiếm đa phương thức rộng hơn."

Các trường hợp sử dụng tiềm năng là đáng kể, và nếu các hệ thống của Meta có thể thiết lập sự phù hợp chính xác hơn giữa các đầu vào khác nhau này, điều đó có thể nâng cao danh mục các công cụ trí tuệ nhân tạo hiện tại, mà dựa trên văn bản và hình ảnh, đến một tầm cao hoàn toàn mới của tương tác. Điều này cũng có thể tạo điều kiện cho việc tạo ra các thế giới VR chính xác hơn, là một yếu tố chính trong sự tiến bộ của Meta đến metaverse. Ví dụ như qua Horizon Worlds, mọi người có thể tạo ra không gian VR của riêng mình, nhưng giới hạn kỹ thuật của nó vào lúc này là nghĩa là hầu hết các trải nghiệm Horizon vẫn rất cơ bản - giống như bước vào một trò chơi video từ những năm 80.

Nhưng nếu Meta có thể cung cấp nhiều công cụ hơn cho phép bất kỳ ai tạo ra bất cứ thứ gì họ muốn trong VR, đơn giản bằng cách nói ra nó trong thực tế, điều đó có thể tạo ra một phạm vi mới hoàn toàn của khả năng, có thể nhanh chóng biến trải nghiệm VR của nó thành một lựa chọn hấp dẫn, lôi cuốn hơn cho nhiều người dùng.

Chúng tôi vẫn chưa đến đó, nhưng các tiến bộ như thế này tiến đến giai đoạn tiếp theo của việc phát triển metaverse, và chỉ ra chính xác vì sao Meta lại nhìn thấy tiềm năng của những trải nghiệm mô phỏng hơn.

Meta cũng ghi nhận rằng ImageBind có thể được sử dụng trong các quy trình trong ứng dụng để tiên tiến hơn.

"Hãy tưởng tượng rằng một người nào đó có thể quay một đoạn video về hoàng hôn trên biển và ngay lặp tức thêm âm thanh hoàn hảo để tăng cường nó, trong khi một hình ảnh của một chú Shih Tzu brindle có thể đưa ra các bài luận hoặc mô hình độ sâu của các chú chó tương tự. Hoặc khi một mô hình như Make-A-Video tạo ra một video về một lễ hội, ImageBind có thể đề xuất tiếng ồn phù hợp để đi kèm với nó, tạo ra một trải nghiệm mô phỏng lôi cuốn."

Đó là một số cách sử dụng sớm của quy trình này, và nó có thể trở thành một trong những tiến bộ đáng kể nhất trong quá trình phát triển trí tuệ nhân tạo của Meta.

Bây giờ chúng ta sẽ chờ xem Meta sẽ sử dụng nó như thế nào và liệu đó có dẫn đến các trải nghiệm AR và VR mới trong các ứng dụng của nó hay không.

Bạn có thể đọc thêm về ImageBind và cách nó hoạt động ở đây. "