ChatGPT được ca ngợi như là một công cụ trí tuệ nhân tạo phi thực tế với khả năng kích động sự không trung thực trong học thuật, khiến cho các công việc trở nên lạc hậu và duy trì định kiến chính trị.

Không ngạc nhiên khi các chính phủ đang thực hiện các biện pháp quyết liệt, nặng tay để đối phó với bài toán nhận dạng AI này. Lệnh cấm ChatGPT của Ý đã khiến cho nhiều quốc gia, bao gồm Pháp, Ireland, Đức và Canada, cân nhắc các chính sách tương tự nhằm chặn chương trình trí tuệ nhân tạo phổ biến của OpenAI. Theo Cơ quan Bảo vệ Dữ liệu của Ý, ChatGPT không có "bất kỳ cơ sở hợp pháp nào để chứng minh cho việc thu thập và lưu trữ đại trà các dữ kiện cá nhân." Cơ quan đã đưa ra một thời hạn 20 ngày để công ty đưa ra các thay đổi hoặc sẽ phải chịu một khoản tiền phạt đáng kể. Trong khi đó, Elon Musk và các nhà lãnh đạo trong ngành đang kêu gọi một "tạm dừng AI".

Vẫn còn quá sớm để xác định ChatGPT có thực sự đáp ứng được những yêu cầu đó hay không. Do ảnh hưởng dài hạn vẫn chưa rõ ràng, những phản ứng bốc đồng như cấm quốc gia sẽ không tạo ra lợi ích cho toàn xã hội. Chính phủ của chúng ta nên tập trung vào giảm thiểu những tổn hại ngay lập tức của trò trò chuyện máy móc, chẳng hạn như thông tin sai lệch và lăng mạ.

CHAT BOT - TRỞ THÀNH MỘT THẬT THƯỢNG HẠNG?

Các trò trò chuyện được đào tạo bằng các mô hình ngôn ngữ lớn, như GPT-4 của OpenAI, Bard của Google và Bing Chat của Microsoft, thuộc vào nhóm công nghệ trí tuệ nhân tạo sinh học, sử dụng hệ thống học máy để tạo ra video, âm thanh, hình ảnh, văn bản và các hình thức truyền thông khác. Trong khi các quy định tại Mỹ đang lâm vào tình trạng vướng mắc về các vấn đề liên quan đến thiên hướng độc đáo của các thuật toán, thường trong bối cảnh của các hệ thống ra quyết định hỗ trợ tuyển dụng và cho vay, trí tuệ nhân tạo sinh học đặt ra một loạt câu hỏi và thách thức mới.

Ví dụ, Dall-E có thể tạo ra hình ảnh và nghệ thuật chân thật dựa trên lời nhắn của người dùng. Như một mô hình học máy, Dall-E tạo ra nội dung mới bằng cách "học" từ các lưu trữ dữ liệu lớn, đôi khi là bằng cách lấy cắp các tác phẩm nghệ thuật và hình ảnh con người. Ý định của Italia là nhắm vào mối lo ngại về quyền riêng tư này, nhưng cuối cùng mọi lệnh cấm đều giả định rằng công nghệ mới nổi đang tiến triển và tiến hóa trước khi chúng được định nghĩa một cách đầy đủ. Hiệu quả của chính sách này phụ thuộc vào mức độ chính xác của các giả định này.

Lệnh cấm trên Quốc gia bỏ qua những ứng dụng tích cực, như tăng hiệu suất và năng suất, làm cho các công việc tẻ nhạt trở nên dễ dàng hơn. Các chuyên gia y tế dự đoán rằng trí tuệ nhân tạo sinh học có thể được sử dụng cho mục đích hành chính và cải thiện trải nghiệm của bệnh nhân. Nếu lệnh cấm được thực hiện thành công, Italia - và các quốc gia khác, theo sau - chỉ cản trở người dùng khỏi việc tận dụng chương trình phổ biến này và cản trở các nhà nghiên cứu trong nước phát triển các hệ thống trí tuệ nhân tạo sinh học. Cũng cần lưu ý rằng các hạn chế ảnh hưởng đến công dân có đạo đức, chứ không phải những kẻ xấu sử dụng công nghệ cho mục đích xấu xa, chẳng hạn như gian lận và gian dối.

NHÀ LẬP PHÁP CHÂU ÂU NHÌN NHẮM ĐẾN CÁC TÁC ĐỘNG TIÊU CỰC CỦA TRÍ TUỆ NHÂN TẠO

Mặc dù các lệnh cấm có thể không phải là giải pháp cho các công nghệ mới nổi, nhưng các điều chỉnh hợp lý và có định hướng có thể làm giảm nhẹ những hại lúc này. Đối với ChatGPT, có một sự khác biệt đáng kể giữa cách công chúng nhận thức về trò trò chuyện máy và khả năng và độ chính xác thực sự của nó. "Học" của nó giống như sự bắt chước và nhái hơn là sự hiểu biết thực sự. Mặc dù chương trình có xu hướng tạo ra các câu trả lời giống như con người, chúng có thể không đầy đủ và trong trường hợp tồi tệ nhất có thể là những sự thật được chế tạo. Bất kể những khuyết điểm này, nhiều người dùng vẫn không kiểm tra tính chính xác của các phản hồi của ChatGPT mà thay vào đó coi chúng như sự thật dựa trên dữ liệu.

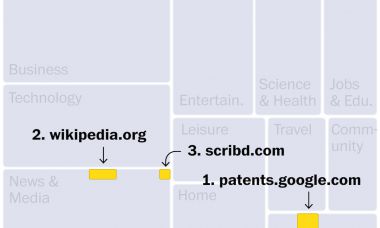

Hãy xem xét lời nhắn đơn giản này mà tôi đã đưa cho ChatGPT: các trích dẫn từ nhà lập pháp về trí tuệ nhân tạo. Nó tiếp tục liệt kê một chuỗi các trích dẫn thuyết phục nhưng hoàn toàn bịa đặt. Tất cả các liên kết đều bị hỏng hoặc không hợp lệ. Tương tự, SCOTUSblog, một trang web phân tích pháp lý, đã hỏi ChatGPT 50 câu hỏi về Tòa Án Tối cao và phát hiện ra rằng chương trình sai hoặc dẫn dụ trong phần lớn các phản hồi của mình. Đối với trò trò chuyện, thành công là dự đoán và sản xuất các phản hồi phù hợp với yêu cầu của người dùng - chứ không phải là độ chính xác.

Thông tin không chính xác có thể có hậu quả nghiêm trọng khi mà có chuyện gì đó quan trọng. Chẳng hạn như sự phỉ báng, có hậu quả pháp lý, nhưng vẫn chưa rõ ai sẽ chịu trách nhiệm cho những người nói chuyện của trí tuệ nhân tạo. Ở Úc, một thị trưởng bị ChatGPT buộc tội một cách sai lầm về hối lộ đang suy tính kiện kiện chống lại OpenAI, đó sẽ là vụ kiện xúc phạm đầu tiên đối với chương trình trò trò chuyện.

Các nhà lập pháp tại Hoa Kỳ và trên toàn thế giới nên đánh giá cách các hệ thống trí tuệ nhân tạo mới nổi tương tác với pháp luật. Những lệnh cấm toàn diện sẽ không làm rõ cuộc mong đợi hợp pháp hoang mang này, tuy nhiên chúng sẽ làm ngăn chặn sự phát triển của một chương trình mà hàng triệu người tìm thấy hữu ích.