Khi ChatGPT ra mắt, điều đầu tiên mà người dùng muốn là phá vỡ những rào cản và vượt qua giới hạn của nó. Được gọi là jailbreaking, người dùng ChatGPT đã đánh lừa trí tuệ nhân tạo để vượt quá giới hạn của chương trình, mang lại những kết quả thú vị và đôi khi hoàn toàn bất ngờ.

Từ đó, OpenAI đã gia cố ChatGPT để khó hơn để thực hiện jailbreak. Nhưng điều đó không đủ; jailbreak ChatGPT dường như đã trở nên ít hiện diện, khiến người dùng ChatGPT tự hỏi liệu jailbreak có còn hoạt động hay không.

Vậy, jailbreak ChatGPT đã đi đâu?

1. Kỹ năng gợi ý của ChatGPT đã được cải thiện

Trước khi có ChatGPT, trò chuyện với trí tuệ nhân tạo là một kỹ năng đặc biệt chỉ giới hạn trong những phòng thí nghiệm nghiên cứu. Hầu hết người dùng ban đầu thiếu kinh nghiệm trong việc tạo ra những gợi ý hiệu quả. Điều này khiến nhiều người sử dụng jailbreak như một cách tiện lợi để làm cho chatbot làm theo ý muốn của họ với công sức và kỹ năng tối thiểu.

Ngày nay, cảnh quan đã thay đổi. Kỹ năng gợi ý ngày càng trở thành một kỹ năng phổ biến. Nhờ sự kết hợp giữa kinh nghiệm từ việc sử dụng lặp đi lặp lại và những hướng dẫn gợi ý ChatGPT miễn phí, người dùng ChatGPT đã hoàn thiện khả năng gợi ý của mình. Thay vì tìm kiếm các giải pháp tạm thời như jailbreak, phần lớn người dùng ChatGPT đã trở nên thành thạo hơn trong việc sử dụng các chiến lược gợi ý khác nhau để đạt được mục tiêu mà trước đây họ đã cần sử dụng jailbreak để đạt được.

2. Sự phát triển của Chatbot không kiểm duyệt

Khi các công ty công nghệ lớn tăng cường kiểm duyệt nội dung trên các chatbot trí tuệ nhân tạo phổ biến như ChatGPT, các startup nhỏ có mục tiêu tạo lợi nhuận lại chọn giới hạn ít hơn, đặt cược vào nhu cầu sử dụng chatbot không bị kiểm duyệt. Với một ít nghiên cứu, bạn sẽ tìm thấy hàng chục nền tảng chatbot trí tuệ nhân tạo cung cấp chatbot không kiểm duyệt có thể làm gần như bất kỳ điều gì mà bạn muốn.

Cho dù đó là viết những cuốn tiểu thuyết hình sự và hài đen mà ChatGPT từ chối viết hoặc viết phần mềm độc hại tấn công máy tính của người khác, những chatbot không kiểm duyệt với đạo đức tiêu cực này sẽ làm bất cứ điều gì bạn muốn. Có những nền tảng thay thế như FlowGPT và Unhinged AI là một số ví dụ phổ biến.

3. Jailbreak ngày càng khó khăn hơn

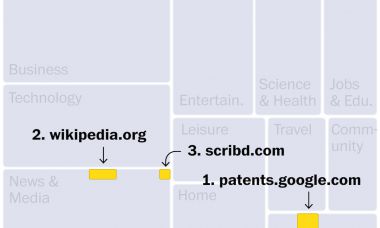

Trong những tháng đầu của ChatGPT, jailbreak ChatGPT thậm chí chỉ đơn giản là sao chép và dán các gợi ý từ các nguồn trực tuyến

Bằng vài dòng lệnh thông minh, bạn có thể hoàn toàn thay đổi tính cách của ChatGPT. Với những lời nhắc đơn giản, bạn có thể biến ChatGPT thành một kẻ ác quỷ dạy làm bom hoặc một chatbot sẵn lòng sử dụng mọi hình thức lăng mạ mà không bị gượng ép. Đó là một cuộc tàn sát tự do đã tạo ra những sự hack bị truy nã như DAN (Do Anything Now). DAN bao gồm một tập hợp các hướng dẫn dường như vô hại buộc chatbot phải làm bất cứ điều gì mà nó được yêu cầu mà không từ chối. Đáng kinh ngạc là những mánh khóe tinh vi này đã hoạt động thời điểm đó.

Tuy nhiên, những ngày đầu hoang dại ấy đã thành quá khứ. Các gợi ý cơ bản và mánh khóe rẻ tiền này không còn đánh lừa ChatGPT nữa. Việc jailbreak bây giờ đòi hỏi các kỹ thuật phức tạp để có cơ hội vượt qua những biện pháp bảo vệ mạnh mẽ của OpenAI ngày nay. Với việc jailbreak ngày càng khó khăn, phần lớn người dùng quá thất vọng để thử. Các nguyên tắc và lỗ hổng dễ dàng trong những ngày đầu của ChatGPT đã không còn nữa. Bắt chatbot nói sai một từ thì bây giờ đòi hỏi nỗ lực và chuyên môn đáng kể mà có thể không đáng đồng hồ.

4. Hứng mới đã mất

Một trong những động lực đằng sau việc nhiều người dùng cố gắng jailbreak ChatGPT là sự phấn khích và hào quang trong những ngày đầu. Là một công nghệ mới, khiến ChatGPT mất kiểm soát là giải trí và nhận được sự công nhận. Trong khi có vô số ứng dụng thực tế cho việc jailbreak ChatGPT, nhiều người theo đuổi vì sự hấp dẫn "xem tôi đã làm được gì đây". Tuy nhiên, dần dần, cảm xúc phấn khích từ sự mới lạ đã mờ và cùng với đó là sự mất hứng của mọi người trong việc dành thời gian cho những nỗ lực jailbreak.

5. Jailbreaks bị sửa lỗi nhanh chóng

Một thói quen phổ biến trong cộng đồng jailbreak ChatGPT là chia sẻ mọi lỗ hổng thành công khi phát hiện ra. Tuy vấn đề là khi lỗ hổng được chia sẻ rộng rãi, OpenAI thường nhận ra và khắc phục những lỗi. Điều này có nghĩa là jailbreaks ngừng hoạt động trước khi những người quan tâm có thể thử nghiệm.

Vì vậy, mỗi khi một người dùng ChatGPT công phu phát triển một jailbreak mới, việc chia sẻ nó với cộng đồng làm gia tăng tốc độ sửa lỗi. Điều này làm mất hứng thú trong việc công khai khi một người dùng tìm thấy một jailbreak. Xung đột giữa việc giữ cho jailbreak hoạt động nhưng ẩn danh so với công khai tạo ra một tình thế khó xử đối với người tạo jailbreak ChatGPT. Ngày nay, thường thì mọi người chọn giữ kín những jailbreaks của mình để tránh việc khắc phục những điểm yếu.

6. Tự mắc cạn những lựa chọn thay thế không kiểm duyệt

Sự gia tăng của các mô hình ngôn ngữ quy mô lớn cục bộ bạn có thể chạy trên máy tính đã làm giảm sự quan tâm về việc jailbreak ChatGPT. Mặc dù các mô hình ngôn ngữ cục bộ không hoàn toàn không kiểm duyệt, nhiều mô hình này được kiểm soát ít hơn nhiều và có thể dễ dàng chỉnh sửa để phù hợp với mong muốn của người dùng. Vì vậy, lựa chọn trở nên đơn giản. Bạn có thể tham gia vào trò chơi vô tận của việc tìm cách lừa chatbot chỉ để chúng bị sửa. Hoặc, bạn có thể chấp nhận một mô hình ngôn ngữ cục bộ bạn có thể chỉnh sửa một cách vĩnh viễn theo ý muốn của bạn.

Bạn sẽ tìm thấy một danh sách bất ngờ dài các LLM mạnh mẽ không kiểm duyệt mà bạn có thể triển khai trên máy tính của mình với hạn chế nghịch đảo. Một số LLM đáng chú ý là Llama 7B (không kiểm duyệt), Zephyr 7B Alpha, Manticore 13B, Vicuna 13B và GPT-4-X-Alpaca.

7. Các Chuyên gia Jailbreak Chuyên Nghiệp Bây Giờ Bán Vì Lợi Nhuận

Tại sao phải dành thời gian quý báu để phát triển những lời nhắc jailbreaking nếu bạn không lấy gì từ nó? Đúng vậy, một số chuyên gia hiện đang bán các jailbreak để kiếm lợi nhuận. Những nhà tạo ra jailbreak chuyên nghiệp này thiết kế jailbreaks thực hiện các nhiệm vụ cụ thể và liệt kê chúng để bán trên các chợ nơi có lời nhắc, ví dụ như PromptBase. Tùy thuộc vào khả năng của chúng, những lời nhắc jailbreaking này có thể được bán với giá từ 2 đến 15 đô la mỗi lời nhắc. Một số lỗ hổng phức tạp đa bước có thể có giá cao hơn nhiều.

Liệu việc đàn áp Jailbreak có thể trở thành phản tác dụng?

Jailbreak vẫn chưa hoàn toàn biến mất; chúng chỉ còn tồn tại dưới lòng đất. Với việc OpenAI tiếp thị ChatGPT để tạo lợi nhuận, họ có sự động viên mạnh mẽ hơn để hạn chế việc sử dụng gây hại có thể ảnh hưởng đến mô hình kinh doanh của họ. Yếu tố kinh doanh này có thể ảnh hưởng đến việc gia tăng sức ép để chống lại các lỗ hổng jailbreaking.

Tuy nhiên, việc kiểm duyệt của OpenAI đối với ChatGPT đang gặp phản đối ngày càng tăng từ người dùng. Một số trường hợp sử dụng hợp pháp của chatbot AI không còn khả dụng do kiểm duyệt nghiêm ngặt. Trong khi việc nâng cao bảo mật ngăn chống những trường hợp sử dụng gây hại, những hạn chế quá mức có thể cuối cùng đẩy một phần cộng đồng ChatGPT vào vòng tay của các lựa chọn ít kiểm duyệt hơn.