Salesforce mới đây đã phát hiện ra rằng 67% các nhà lãnh đạo IT cấp cao đang đẩy nhanh việc áp dụng trí tuệ nhân tạo sinh sản trong toàn bộ doanh nghiệp của họ trong vòng 18 tháng tới, trong đó có một phần ba đặt nó là ưu tiên hàng đầu của họ.

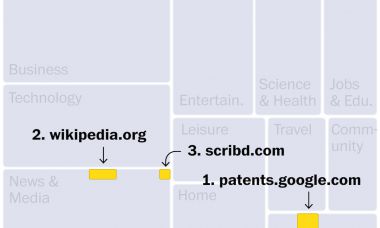

Đồng thời, đa số các nhà lãnh đạo IT cấp cao này cũng có quan ngại về những gì có thể xảy ra. Trong số các dự đoán và quan ngại này, báo cáo đã phát hiện ra rằng 59% tin rằng các sản phẩm của trí tuệ nhân tạo sinh sản là không chính xác và 79% có các vấn đề liên quan đến an ninh.

Trong khi những tổ chức đang áp dụng trí tuệ nhân tạo sinh sản, đồng thời cũng đang đẩy mạnh việc nghiên cứu phát triển công nghệ. Việc này dẫn đến một nguy cơ sai lầm do thiếu rõ ràng.

Gần đây, một tổ chức phi lợi nhuận chuyên về rối loạn ăn uống có tên NEDA đã thực hiện việc thay thế đội ngũ tư vấn gồm 6 người và 20 tình nguyện viên bằng một trợ lý ảo tên Tessa. Tuy nhiên, sau đó một tuần, NEDA đã phải tắt Tessa xuống sau khi phát hiện ra trợ lý ảo đưa ra các lời khuyên gây hại có thể làm cho tình trạng rối loạn chức năng tiêu hóa trở nên trầm trọng hơn.

Tôi đã từng phát biểu tại Hội nghị Thay đổi số hóa do Procter & Gamble tổ chức. Một trong những chuyên viên pháp lý của họ đã nói về thách thức cân bằng giữa sự cấp bách và các biện pháp bảo vệ trong thời đại chuyển đổi số. Cô ta chia sẻ một mô hình để đưa ra thời gian cho sự thử nghiệm: “tự do trong khung việc đó”.

Sự người tham vấn đạo đức của BCG, Steven Mills, đã đề xuất phương pháp “tự do trong khung việc đó” cho trí tuệ nhân tạo. Cụ thể là:

“Quan trọng là những người tham gia phải có cơ hội giao tiếp với các công nghệ và sử dụng chúng. Dừng xuống không phải là giải pháp. Trí tuệ nhân tạo sẽ được phát triển từ các nhân viên trong toàn bộ doanh nghiệp của bạn, dù bạn có biết điều đó hay không…

"Thay vì giả vờ như nó sẽ không xảy ra, hãy thiết lập một tập hợp nguyên tắc nhanh để cho nhân viên của bạn biết đâu là các thanh chắn và khuyến khích sự đổi mới và thử nghiệm có trách nhiệm.”

Một trong những biện pháp bảo vệ mà Salesforce đề xuất là quy trình làm việc “con người ở vòng lặp”. Hai kiến trúc sư của Salesforce về đạo đức trí tuệ nhân tạo, Kathy Baxter và Yoav Schlesinger, đã nói rằng:

“Chỉ vì có thể tự động hóa điều gì đó không có nghĩa là nên làm như vậy. Các công cụ trí tuệ nhân tạo sinh sản không luôn có khả năng hiểu rõ ngữ cảnh cảm xúc hoặc kinh doanh hoặc biết khi nào bạn sai hoặc gây thiệt hại.

"Con người cần được tham gia để xem xét kết quả đầu ra để đảm bảo tính chính xác, suss ra độ lệch và đảm bảo các mô hình hoạt động như dự định. Nhiều hơn nữa, trí tuệ nhân tạo sinh sản nên được xem như một cách để tăng cường khả năng của con người và giúp cộng đồng, chứ không phải thay thế hoặc thay thế họ."

Đây là một vài tranh liên quan tôi đã vẽ suốt những năm qua:

"Nếu bộ phận tiếp thị vẫn giữ một nhật ký, đó sẽ là nó." - Ann Handley, Giám đốc nội dung của MarketingProfs. Đặt hàng ngay.