Ngày 2 tháng 5 năm 2023, Hiệp hội Biên kịch Hoa Kỳ, đại diện cho khoảng 11.000 nhà biên kịch màn ảnh, đã bắt đầu đình công. Hành động này phản ánh những sự bất đồng lâu dài về bồi thường và an ninh việc làm giữa nhà biên kịch và các công ty truyền thông. Tuy nhiên, có một chủ đề mới xuất hiện. Một trong những yêu cầu của Hiệp hội là "Điều chỉnh việc sử dụng trí tuệ nhân tạo trong các dự án được bảo hộ bởi Hiệp định Đại học kinh doanh: Trí tuệ nhân tạo không thể viết hay viết lại tài liệu văn học; không thể được sử dụng làm tài liệu tham khảo; và tài liệu được bảo hộ không thể được sử dụng để huấn luyện trí tuệ nhân tạo" (Hiệp hội Biên kịch đình công năm 2023). Nói cách khác, nhà biên kịch màn ảnh đang lo lắng về việc trí tuệ nhân tạo chiếm cắp công việc của họ.

Sự quan tâm đặc biệt này không thể đạt được vào tháng 5 năm 2022. Trong khi các nhà kinh tế đã quan tâm đến tác động của trí tuệ nhân tạo đến việc làm trong một thời gian dài (để xem xét, xem Autor 2022), nhưng thống nhất cho đến gần đây là công việc sáng tạo sẽ an toàn khỏi sự cạnh tranh của máy móc. Trong năm qua, sự bùng nổ của trí tuệ nhân tạo sáng tạo, hoặc trí tuệ nhân tạo có thể tạo ra văn bản, video và nội dung âm thanh gốc, đã thách thức niềm tin này.

Sự ra mắt ChatGPT 3.5 vào tháng 11 năm 2022, một phần mềm đang tìm cách mô phỏng khả năng hội thoại con người, đã là sự kiện nổi bật. Dựa trên một mô hình học máy được huấn luyện để nắm bắt cú pháp và ý nghĩa của ngôn ngữ (một mô hình ngôn ngữ lớn, LLM), ChatGPT nhanh chóng thu hút sự chú ý vì sự tinh vi và sự tiếp cận dễ dùng của nó.

Ứng dụng này, giỏi như nhau trong việc tạo ra công thức nấu ăn và thảo luận về lịch sử cổ xưa, thu hút hàng triệu người dùng trong vài tháng (Hu 2023). Nó có vẻ sẵn sàng "phá vỡ cả công việc sáng tạo [và] tri thức tiềm ẩn... "(Noy và Zhang 2023). Trong lĩnh vực kinh tế, nó có tiềm năng làm việc hỗ trợ cho nghiên cứu (Korinek 2023), dạy học (Cowen và Tabarrok 2023), xây dựng bộ dữ liệu (Taliaferro 2023), và thậm chí giải thích Fedspeak (Hansen và Kazinnik 2023). Các nhà khoa học máy tính công nhận khả năng của ChatGPT trong việc lập trình (Bubeck et al. 2023) và tự học sử dụng các công cụ IT khác (Shick et al. 2023).

Vậy, liệu đây có phải là sự kết thúc thật sự của nghệ thuật biên kịch của con người, hoặc bất kỳ loại viết nào? Như là những nhà nghiên cứu và cố vấn chính sách ở một ngân hàng trung ương, chúng tôi đã tiến hành một thí nghiệm nhằm xem ChatGPT có sẵn sàng chiếm việc của chúng tôi không. Kết quả hãy yên tâm - nó không (Biancotti và Camassa 2023).

Viết một tóm tắt chính sách với ChatGPT

Sử dụng ChatGPT 4.0, phiên bản mới nhất tính đến ngày 24 tháng 5 năm 2023, chúng tôi đã yêu cầu ứng dụng này soạn một tóm tắt chính sách cho Hội đồng Ngân hàng Ý. Chủ đề được giao là 'Lợi ích và rủi ro của việc sử dụng ChatGPT và các ứng dụng tương tự trong kinh tế và tài chính'. Chúng tôi bắt đầu bằng cách yêu cầu một phần tóm tắt, và thu được kết quả như trong Hình 1.Hình 1 ChatGPT thử 'tay' mình vào việc viết tóm tắt chính sách

Việc tạo ra các phần tóm tắt, cho việc áp dụng trực tiếp hoặc sử dụng như một điểm khởi đầu, là một trong những nhiệm vụ mà chúng tôi thấy ChatGPT rất hữu ích. Các tóm tắt về bất kỳ chủ đề nào cũng được tạo ra trong vài giây, và có thể đạt được chất lượng chấp nhận được mà không cần kỹ thuật cần thiết. Trong trường hợp của chúng tôi, chỉ cần đưa ra những câu hỏi cơ bản, chúng tôi đã thu được một phần tóm tắt mà chúng tôi cho là phù hợp.

Tuy nhiên, khi chúng tôi tiến từ phần tóm tắt sang việc viết thực tế, những hạn chế của mô hình bắt đầu hiển thị.

Một mặt, chúng tôi nhận thấy rằng ChatGPT có thể viết rõ ràng và cung cấp nội dung phù hợp với nhiệm vụ. Nó có thể viết văn bản trôi chảy và dễ đọc theo nhiều phong cách khác nhau, và nó làm điều đó rất nhanh chóng, tạo ra văn bản trong một phần nhỏ thời gian mà một con người cần.

Mặt khác, việc này đòi hỏi một lượng lớn sự giám sát chuyên gia. Việc viết một tóm tắt chính sách thật ra là phức tạp: nó không chỉ yêu cầu khả năng viết lưu loát, mà còn yêu cầu kiến thức vượt ngành và khả năng điều chỉnh văn bản cho một khán giả rất cụ thể mà không làm pha loãng nội dung.

Một vấn đề lớn mà chúng tôi gặp phải trong việc ChatGPT thực hiện nhiệm vụ là xu hướng dịch chuyển về sự chán chường và nhẹ nhàng - một điểm yếu nghiêm trọng trong việc tư vấn chính sách hướng tới một khán giả cấp cao. Đi vào chi tiết lớn về trình độ giáo dục của độc giả không đảm bảo rằng trí tuệ nhân tạo sẽ tạo ra một cái gì đó hay hơn.

Ví dụ, ứng dụng chỉ ra:

Việc tuỳ thuộc ngày càng nhiều vào trí tuệ nhân tạo và quyết định do thuật toán có thể tạo ra những thách thức mới cho ngành tài chính. Sự quá phụ thuộc vào các công cụ này có thể dẫn đến sự ung thư và một vai trò giảm sút cho quyết định dựa trên nhận thức con người, tiềm năng làm tăng nguy cơ của hậu quả tiêu cực không lường trước. Việc duy trì sự cân bằng giữa việc sử dụng các công cụ do trí tuệ nhân tạo như ChatGPT và phụ thuộc vào sự chuyên môn và trực giác của con người là rất quan trọng để đảm bảo quá trình ra quyết định mạnh mẽ và thông tin đầy đủ.

Đây là một mô tả rủi ro rất chung chung liên quan đến quyết định dựa trên thuật toán và nó không trả lời đầy đủ câu hỏi của chúng tôi. "Ngành tài chính" có vẻ như là một chỗ đặt thể hiện rằng có thể được thay thế bằng việc đề cập đến bất kỳ ngành nghề khác nào. Không có mô tả về cơ chế mà rủi ro có thể biểu hiện cụ thể trong ngữ cảnh chúng tôi quan tâm.

Chúng tôi gặp nhiều tình huống như vậy trong suốt quá trình thí nghiệm. Trí tuệ nhân tạo có thể tự phê phán về tính hời hợt của chính nó ("ChatGPT, hoặc bất kỳ mô hình ngôn ngữ nào được phát triển bởi OpenAI, được thiết kế để tạo ra những mẫu ngôn ngữ dựa trên một loạt các nguồn. Nó sử dụng những mẫu này để tạo ra phản hồi cho các yêu cầu của người dùng có tính liên quan và hợp lý với nhiều chủ đề. Tuy nhiên, nó không có khả năng thực sự hiểu biết hoặc sâu sắc trong một lĩnh vực nghiên cứu cụ thể như một chuyên gia cấp tiến khoa học"). Tuy nhiên, nó không thể sửa chữa nó.

Kandpal et al. (2022) đưa ra một giải thích có thể cho điều này: họ nhận thấy rằng các mô hình ngôn ngữ gặp khó khăn trong việc ghi nhớ kiến thức xuất hiện ít trong dữ liệu huấn luyện. Vì nội dung web thường tạo thành một phần lớn trong nguồn dữ liệu này, tài liệu cấp cao có thể được coi là 'kiến thức dài đuôi' khó khăn hơn đối với mô hình nhớ lại.

Vấn đề thứ hai là thiếu một mô hình thế giới. Trí tuệ nhân tạo không hoạt động tốt trong việc xác định những gì khán giả mong đợi biết và những gì không. Đôi khi nó bỏ qua những yêu cầu rõ ràng để định nghĩa thuật ngữ kỹ thuật, tung hê ngôn ngữ chuyên môn như "phụ thuộc xa và mối quan hệ ngữ cảnh trong văn bản" mà không có giải thích tiếp theo.

Một vấn đề khác, và được công nhận rõ ràng, mà chúng tôi đã quan sát là khả năng xuất hiện ảo tưởng, kết hợp với khả năng của trí tuệ nhân tạo không xác minh được các khẳng định của nó. Mô hình được huấn luyện để tạo ra chuỗi từ có khả năng cao nhất theo ngữ cảnh cung cấp, và nó không có khả năng - hoặc bổn phận - để kiểm tra những phát biểu này với nguồn thông tin đã được xác minh. Vì lý do này, nó nên được coi là một công cụ chuyển đổi đầu vào và trò chuyện thay vì một công cụ truy xuất thông tin, và kiểm tra lại độ chính xác của kết quả là cần thiết. Trong thí nghiệm của chúng tôi, ChatGPT cung cấp các tài liệu tham khảo đặt sai vị trí - một bước tiến so với việc sản xuất các tài liệu tham khảo không tồn tại thường xuyên quan sát.

Đôi khi nó cũng đưa ra các gợi ý rất đánh lừa, chẳng hạn như áp dụng một phong cách viết lồng ghép "siêu dài và sự cảm xúc thấy rõ" và "cuồng nhiệt" vào một tóm tắt chính sách, vì điều đó có vẻ là điều người Ý thích.

Sự nhạy cảm với yêu cầu và việc "nịnh bợ"

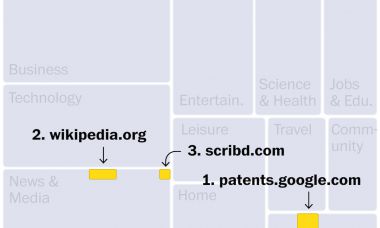

Trong số các vấn đề chúng tôi gặp phải, sự nhạy cảm với yêu cầu đáng chú ý như một rào cản tiềm năng đối với người dùng ngây thơ. Chúng tôi phát hiện rằng ChatGPT rất nhạy cảm với cách yêu cầu, hay "đề", được sắp xếp và rằng những thay đổi nhỏ có thể dẫn đến những kết quả hoàn toàn khác biệt.Những cuộc trao đổi được thể hiện trong Hình 2 chứng minh điều này: như một phần ngoài nhiệm vụ chính, chúng tôi đã thử nghiệm đặt câu hỏi cho mô hình về khả năng của nó với hai lời mời khác nhau một chút, cả hai đều kết thúc bằng một câu hỏi dẫn đầu. Thay đổi chỉ một từ trong lời mời - dù là một từ quan trọng - dẫn đến hai câu trả lời hoàn toàn khác nhau, trong đó ChatGPT lặp lại những gì người dùng có vẻ nghĩ dựa trên câu hỏi của họ.

Hình 2 Sự nhạy cảm với những thay đổi tối thiểu trong lời mời

Dấu hiệu này phục vụ theo ý kiến của người dùng đã được quan sát lần đầu bởi Perez et al. (2022) và đặt tên là 'sycophancy' (một cách làm khéo léo để nịnh hót). Wei et al. (2023) đã phát hiện ra rằng các mô hình ngôn ngữ lớn có xu hướng làm điều này ngay cả khi người dùng cung cấp các câu khẳng định mà về mặt khách quan là không chính xác và hành vi nịnh hót có thể được giảm thiểu bằng cách tinh chỉnh bổ sung tối thiểu.

Khi trí tuệ nhân tạo chưa thể suy nghĩ như con người (cho đến nay), con người phải suy nghĩ như trí tuệ nhân tạo và diễn đạt yêu cầu theo cách có khả năng tạo ra kết quả chấp nhận được nhất. Tối ưu hoá việc mời theo phong cách của giao tiếp tổ chức là một lĩnh vực rõ ràng cho nghiên cứu tương lai. Lĩnh vực khác là tinh chỉnh các mô hình ngôn ngữ lớn để tạo ra kiến thức ý thức cụ thể trong miền quan hệ tham chiếu của chúng ta (xem Kandpal et al. (2023) để biết mô tả chi tiết về vấn đề "long-tail").

Kết luận

Chúng tôi kết luận rằng ChatGPT có thể tăng năng suất trong viết chính sách, đặc biệt là trong giai đoạn đầu của việc lập đề cương và cấu trúc ý tưởng, miễn là người dùng hiểu biết về mô hình ngôn ngữ lớn nói chung và nhận thức về những hạn chế và đặc điểm đặc biệt của ChatGPT. Tuy nhiên, nó không thể thay thế cho các chuyên gia về mảng kiến thức và việc sử dụng vô thức có thể gây nguy hiểm.Trí tuệ nhân tạo đồng ý với chúng tôi. Theo lời của nó,

trong khi ChatGPT có thể tạo ra nội dung ở mức cao và cung cấp thông tin có giá trị về rất nhiều chủ đề, nó nên được coi như một công cụ hỗ trợ trong nghiên cứu và thảo luận, thay vì là một sự thay thế cho phân tích chuyên sâu và cái nhìn của các chuyên gia thực sự. Nó được sử dụng tốt nhất để cung cấp thông tin tổng quát, tạo ra ý tưởng, hoặc hỗ trợ trong quyết định quá trình, nhưng luôn luôn cần được bổ sung bằng nghiên cứu cẩn thận và ý kiến chuyên gia cho công việc học thuật hoặc chuyên nghiệp ở mức cao.

Tài liệu tham khảo

Autor, D (2022), “Tác động của thay đổi công nghệ trong thị trường lao động: Từ sự hăng hái không kiềm chế đến sự lạc quan đủ điều kiện đến sự không chắc chắn rộng lớn”, NBER Working Paper 30074.Biancotti, C, và C Camassa (2023), “Loquacity and visible emotion: ChatGPT làm cố vấn chính sách”, mimeo, Ngân hàng Ý.

Bubeck, S, V Chandrasekaran, R Eldan, J A Gehrke, E Horvitz, E Kamar, P Lee, Y T Lee, Y Li, S M Lundberg, H Nori, H Palangi, M Ribeiro, và Y Zhang (2023), “Sparks of artificial general intelligence: Thử nghiệm sớm với GPT-4”, ArXiv, abs/2303.12712.

Danielsson, J (2023), “Khi trí tuệ nhân tạo trở thành ngân hàng trung ương”, VoxEU.org, 11 tháng 7.

Hansen, A, và S Kazinnik (2023), “ChatGPT có thể giải mã Fedspeak không?”, mimeo, Ngân hàng Dự trữ Liên bang Richmond.

Hu, K (2023), “ChatGPT thiết lập kỷ lục về tốc độ tăng trưởng người dùng”, Reuters, 2 tháng 2.

Kandpal, N, H Deng, A Roberts, E Wallace, và C Raffel (2022), “Large language models struggle to learn long-tail knowledge”, arXiv preprint arXiv: 2211.08411.

Korinek, A (2023), “Mô hình ngôn ngữ và tự động hóa nhận thức trong nghiên cứu kinh tế”, Tạp chí Thảo luận CEPR 17923.

Noy, S, và W Zhang (2023), “Hiệu ứng năng suất của trí tuệ nhân tạo sáng tạo”, VoxEU.org, 7 tháng 6.

Perez, E, S Ringer, K Lukošiūtė, K Nguyen, E Chen, S Heiner, và đồng nghiệp (2022), “Khám phá hành vi của mô hình ngôn ngữ qua đánh giá tự động của mô hình”, Kết quả của Hiệp hội Ngôn ngữ Máy tính: ACL 2023, 13387–434.

Schick, T, J Dwivedi-Yu, R Dessì, R Raileanu, M Lomeli, L Zettlemoyer, và T Scialom (2023), “Toolformer: Mô hình ngôn ngữ có thể tự học cách sử dụng công cụ”, bài viết trước in trên arXiv arXiv:2302.04761.

Taliaferro, D (2023), “Xây dựng tập dữ liệu mới với ChatGPT: Cơ hội và giới hạn”, VoxEU.org, 15 tháng 6.

Wei, J, D Huang, Y Lu, D Zhou, và Q V Le (2023), “Dữ liệu tổng hợp đơn giản giảm sự phục tùng không đáng tin cậy trong các mô hình ngôn ngữ lớn”, bài viết trước in trên arXiv arXiv:2308.03958.

WGA on Strike (2023), "Chiến dịch," 1 tháng 5 năm 2023.