Trong bối cảnh lo ngại những nhân viên có thể nhập thông tin nhạy cảm vào mô hình trí tuệ nhân tạo ChatGPT, một nhà cung cấp bảo mật dữ liệu đã ra mắt công cụ che dấu nhằm giảm thiểu rủi ro cho các công ty vô tình tiết lộ thông tin khách hàng và nhân viên.

Nền tảng PrivateGPT mới của Private AI được tích hợp với chatbot nổi tiếng của OpenAI, tự động che dấu 50 loại thông tin cá nhân có thể để nhận diện (PII) trong thời gian thực khi người dùng nhập các lời nhắc cho ChatGPT.

PrivateGPT ngồi ở giữa quá trình trò chuyện, loại bỏ tất cả từ dữ liệu sức khỏe và thông tin thẻ tín dụng cho đến thông tin liên lạc, ngày sinh và số an sinh xã hội từ lời nhắc của người dùng, trước khi gửi chúng đến ChatGPT. Khi ChatGPT phản hồi, PrivateGPT sẽ gửi lại PII trong câu trả lời, để trải nghiệm trở nên mượt mà hơn đối với người dùng, theo tuyên bố của Private AI vào tuần này.

CEO của Private AI, Patricia Thaine nói, "Trí tuệ nhân tạo tạo sẽ chỉ có chỗ trong các tổ chức và xã hội của chúng ta nếu có các công cụ phù hợp để sử dụng an toàn," trong một tuyên bố. "Bằng cách chia sẻ thông tin cá nhân với các tổ chức bên thứ ba, [các công ty] mất kiểm soát về cách dữ liệu đó được lưu trữ và sử dụng, đặt chính mình trong tình trạng rủi ro nghiêm trọng về vi phạm tuân thủ."

Rủi ro về quyền riêng tư & ChatGPTMỗi khi người dùng nhập dữ liệu vào lời nhắc cho ChatGPT, thông tin sẽ được tiết kiệm vào tập dữ liệu LLM của dịch vụ, được sử dụng để đào tạo thế hệ tiếp theo của thuật toán. Nguy cơ là thông tin có thể được khôi phục vào một ngày sau nếu không có biện pháp bảo mật dữ liệu phù hợp cho dịch vụ.

"Khía cạnh của trí tuệ nhân tạo tiêu thụ tất cả đầu vào như vật liệu nguồn cho các truy vấn khác nhau tạo ra hộp đen không chắc chắn về cách và nơi mà dữ liệu của một công ty sẽ kết thúc và hoàn toàn chống lại tính bảo mật dữ liệu chặt chẽ ở trung tâm của hầu hết tất cả các công ty hiện nay," cảnh báo Roy Akerman, đồng sáng lập và CEO của Rezonate.

Nên nhớ rằng nguy cơ tiết lộ thông tin không phải là lý thuyết: OpenAI vào tháng 3 đã thừa nhận một lỗi phát hành lịch sử trò chuyện của người dùng, sau khi các ảnh chụp màn hình của cuộc trò chuyện riêng tư bắt đầu xuất hiện trên Reddit.

OpenAI cảnh báo người dùng phải lựa chọn cẩn thận khi sử dụng ChatGPT: "Chúng tôi không thể xóa những lời nhắc cụ thể trong lịch sử của bạn. Xin đừng chia sẻ bất kỳ thông tin nhạy cảm nào trong cuộc trò chuyện của bạn," hướng dẫn sử dụng người dùng của OpenAI chỉ ra.

Tuy nhiên, nhân viên vẫn đang học cách xử lý quyền riêng tư khi sử dụng ChatGPT, ngay cả khi dịch vụ này nhận được số lượng sử dụng khổng lồ (đạt cột mốc 100 triệu người dùng trong thời gian ngắn kỷ lục chỉ sau 2 tháng ra mắt).

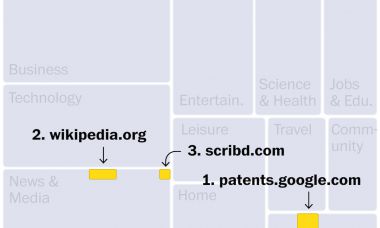

Trong một báo cáo gần đây, dịch vụ bảo mật dữ liệu Cyberhaven đã phát hiện và ngăn chặn các yêu cầu nhập dữ liệu nhạy cảm vào ChatGPT từ 4,2% trong số 1,6 triệu công nhân của các công ty khách hàng của mình, bao gồm thông tin bí mật, dữ liệu khách hàng, mã nguồn và thông tin được quy định.

Là một ví dụ cụ thể về hiện tượng này, cách đây ít ngày, đã được biết đến rằng các kỹ sư của Samsung đã làm rò rỉ ba lần quan trọng đến ChatGPT: mã nguồn lỗi từ cơ sở dữ liệu bán dẫn, mã để xác định khuyết tật trong một số thiết bị Samsung và thông tin cuộc họp nội bộ.

"Việc sử dụng rộng rãi các mô hình ngôn ngữ trí tuệ nhân tạo đang được chấp nhận rộng rãi như một phương tiện để tăng tốc các công việc sáng tạo mã và phân tích," Akerman nói. "Tuy nhiên, rò rỉ dữ liệu thường là sản phẩm phụ của tốc độ, hiệu quả và chất lượng đó. Các nhà phát triển trên toàn thế giới đang háo hức sử dụng những công nghệ này, tuy nhiên, hướng dẫn từ quản lý kỹ thuật vẫn chưa được ban hành về những điều cần và không cần làm khi sử dụng trí tuệ nhân tạo để đảm bảo sự tôn trọng và duy trì quyền riêng tư của dữ liệu."