Vào thứ Năm vừa qua, các nhà lập pháp Liên minh châu Âu đã đạt được thỏa thuận chính thức về những quy định về Trí tuệ nhân tạo (AI) có thể trở thành bộ luật đầu tiên do một cơ quan pháp quy của cấp độ lớn đưa ra. Các thành viên của các nước thành viên Liên minh châu Âu (MEP) đã thảo luận về nội dung của AI Act của EU và đã đồng ý với những sửa đổi giữa một vài phút cuối về generative AI.

"Những sự sửa đổi đã được thỏa thuận trong các cuộc đàm phán nội bộ giữa các báo cáo viên và báo cáo viên bóng ma ngày hôm qua và sẽ được các MEP bỏ phiếu vào ngày 11 tháng 5 năm 2023", một quan chức của Quốc hội nói. "Sau đó sẽ có phiếu bầu trong khuôn khổ đại hội vào tháng 6, sau đó sẽ có cuộc đàm phán với Hội đồng (các nước thành viên) với mong muốn đạt được thỏa thuận song phương trước khi kết thúc năm."

Ủy ban Châu Âu, được coi là bộ phận điều hành của Liên minh châu Âu, đã làm việc về khung pháp lý cho AI từ đầu năm 2020. Vào tháng 4 năm 2021, Ủy ban đưa ra một bộ quy định nháp cho AI Act, nhằm cung cấp khung pháp lý toàn diện cho việc phát triển và triển khai hệ thống AI trong EU.

Các quy định đề xuất bao gồm rất nhiều ứng dụng AI và dự kiến giúp tăng cường độ tin cậy và minh bạch trong việc sử dụng AI, bảo vệ quyền và tự do cơ bản và đảm bảo an toàn và nguyên tắc đạo đức trong việc phát triển và triển khai AI.

Việc xử lý hệ thống AI không phục vụ cho một trường hợp sử dụng cụ thể đã là vấn đề được thảo luận nhiều nhất trong đề xuất. Hệ thống AI đa dụng xử lý nhiều công việc và ban đầu không được bao gồm trong đề xuất ban đầu. Chúng chỉ được xem xét sau sự cố gây ra bởi ChatGPT, một mô hình AI sinh đa dụng, sinh sản chất lượng cao, dựa trên văn bản đầu vào và đưa ra các phản hồi dựa trên ngữ cảnh cho người dùng.

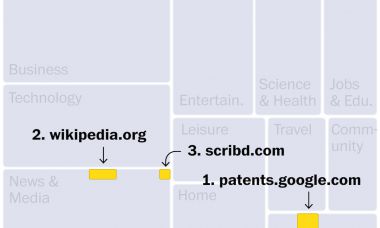

Những bản sửa đổi đã đồng ý rằng các công cụ sinh đa dạng như ChatGPT, DALL-E và Midjourney phải được điều chỉnh về thiết kế và triển khai để phù hợp với pháp luật của EU và quyền cơ bản, bao gồm tự do ngôn luận. Một thay đổi lớn được thực hiện trong Luật là các công cụ này sẽ phải tiết lộ bất kỳ tài liệu có bản quyền nào được sử dụng để phát triển hệ thống của họ.

Yêu cầu khác cho các mô hình AI sinh đa dạng bao gồm kiểm tra và giảm thiểu các rủi ro có thể dự đoán được về sức khỏe, an toàn, quyền cơ bản, môi trường, dân chủ và quyền pháp luật, với sự tham gia của các chuyên gia độc lập.

Đạo luật cũng đòi hỏi tài liệu về các rủi ro không thể được giảm thiểu trong các mô hình AI và lý do tại sao chúng không được đề cập đến. Nhiều người lo ngại rằng ChatGPT có thể được sử dụng cho mục đích độc hại, bao gồm tạo ra các tài liệu lừa đảo, các tải trọng chiếm dụng thông tin, binary scripts DDoS và ransomware.

Các chuyên gia đặt câu hỏi liệu quy định cho các hệ thống dựa trên các mô hình ngôn ngữ lớn (LLM), chẳng hạn như ChatGPT và DALL-E, có thể được ban hành mà không làm ảnh hưởng đến chức năng cốt lõi của chúng.

"Đơn giản - tôi không biết làm thế nào để quy định một cái gì đó như Chat GPT mà không làm giảm hiệu quả của giải pháp của họ ", Chris Steffen, một nhà phân tích tại Enterprise Management, nói. "Bên cạnh đó, những trường hợp được tạo ra đặc biệt cho các mục đích độc hại thì sao? Khi công nghệ trở nên phổ biến và có thể truy cập được, các kẻ xấu sẽ có thể (và sẽ) thiết lập riêng của họ 'bad guy Chat AI' để làm bất cứ điều gì họ muốn và tối ưu hóa cho mục đích đó. Vì vậy, liệu bạn có thể (và có thể) quy định công nghệ? Không có khả năng”.

Ai Act nhất quán tuân theo hệ thống phân loại

Ngoài vấn đề thảo luận gần đây về AI đa mục đích, đạo luật chủ yếu tập trung vào việc phân loại các giải pháp AI hiện có thành các loại dựa trên nguy cơ - không chấp nhận được, cao, giới hạn và tối thiểu.

Các hệ thống AI mà chỉ đưa ra các rủi ro hạn chế và tối thiểu, chẳng hạn như các hệ thống được sử dụng cho bộ lọc rác hoặc trò chơi video, có thể được sử dụng với ít yêu cầu miễn là có tính minh bạch. Tuy nhiên, các hệ thống AI gây ra rủi ro không thể chấp nhận được, như những hệ thống được sử dụng cho các hệ thống xã hội đánh giá chính phủ và các hệ thống nhận diện sinh trắc học thời gian thực trong khu vực công cộng, sẽ không được phép thông thường với một số ngoại lệ.

Các nhà phát triển và người dùng được phép sử dụng các hệ thống AI có rủi ro cao, nhưng họ phải tuân theo các quy định yêu cầu kiểm tra tỉ mỉ, tài liệu đúng chất lượng dữ liệu và một khung trách nhiệm giúp đưa ra giám sát con người. Một số ví dụ về các hệ thống AI được xem là có nguy cơ cao bao gồm các xe tự hành, thiết bị y tế và máy móc cơ sở hạ tầng quan trọng.

Cuộc thỏa thuận đạt được vào thứ Năm cuối cùng cũng hoàn thiện văn bản, vẫn còn chịu sự điều chỉnh nhỏ trước khi bỏ phiếu vào ngày 11 tháng 5 năm, trong đó tất cả các nhóm sẽ phải bỏ phiếu cho sự thoả hiệp mà không có khả năng đề xuất các sửa đổi khác.