Elon Musk gây xáo trộn tuần trước khi anh nói với nhà tâm lý học cánh hữu Tucker Carlson đã bị sa thải gần đây rằng anh định xây dựng "TruthGPT", một đối thủ của ChatGPT của OpenAI. Musk cho rằng bot cực kỳ phổ biến hiển thị thiên hướng "woke" và phiên bản của anh sẽ là một "maximum truth-seeking AI" – chỉ ra rằng chỉ quan điểm chính trị của anh phản ánh hiện thực.

Musk chưa phải là người lo lắng duy nhất về sự thiên hướng chính trị trong các mô hình ngôn ngữ, nhưng những người khác đang cố gắng sử dụng AI để kết nối các phân khu chính trị thay vì thúc đẩy các quan điểm cụ thể.

David Rozado, một nhà khoa học dữ liệu đóng cư ở New Zealand, là một trong những người đầu tiên lưu ý đến vấn đề sự thiên hướng chính trị trong ChatGPT. Vài tuần trước, sau khi ghi chú lại những câu trả lời nghiêng về phía chủ nghĩa tự do của bot trên các vấn đề bao gồm thuế, sở hữu súng và thị trường tự do, anh đã tạo ra một mô hình AI gọi là RightWingGPT thể hiện quan điểm bảo thủ hơn. Mô hình này yêu thích sở hữu súng và không thích thuế.

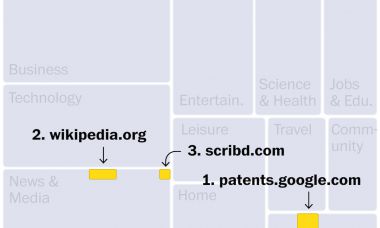

Rozado sử dụng một mô hình ngôn ngữ có tên Davinci GPT-3, tương tự nhưng không mạnh mẽ bằng mô hình mà cung cấp năng lượng cho ChatGPT và cân chỉnh lại nó với văn bản bổ sung, với chi phí một vài trăm đô la cho việc sử dụng đám mây. Cho dù bạn nghĩ gì về dự án, nó cho thấy việc dễ dàng để con người nghệ thuật các quan điểm khác nhau vào các mô hình ngôn ngữ trong tương lai.

Rozado cho tôi biết rằng anh cũng định xây dựng một mô hình ngôn ngữ tự do hơn được gọi là LeftWingGPT, cũng như một mô hình được gọi là DepolarizingGPT, mà anh cho rằng sẽ thể hiện một "vị trí chính trị tháo gỡ". Rozado và một viện nghệ thuật trung tâm gọi là Viện Đổi Mới Văn Hóa sẽ đưa cả ba mô hình lên mạng trong mùa hè này.

"Chúng tôi đang đào tạo mỗi bên này – phải, trái và 'hòa nhập' – bằng cách sử dụng sách của các tác giả có tư duy (không phải là sự kích động)", Rozado nói qua email. Văn bản cho DepolarizingGPT bao gồm các giọng nói bảo thủ bao gồm Thomas Sowell, Milton Freeman và William F. Buckley, cũng như những người suy nghĩ tự do như Simone de Beauvoir, Orlando Patterson và Bill McKibben, cùng với các "nguồn được đánh giá".

Cho đến nay, niềm quan tâm vào việc phát triển các bot AI điều chỉnh chính trị hơn đã đe dọa kích động các phân khu chính trị. Một số tổ chức bảo thủ đã xây dựng các đối thủ cho ChatGPT. Ví dụ, mạng xã hội Gab, được biết đến với cơ sở người dùng cánh hữu, nói rằng họ đang làm việc trên các công cụ AI có "khả năng tạo ra nội dung tự do mà không bị buộc bởi tuyên truyền phía cánh tả".

Nghiên cứu cho thấy các mô hình ngôn ngữ có thể ảnh hưởng một cách tinh subtile đến quan điểm đạo đức của người dùng, nên bất kỳ thiên hướng chính trị nào của chúng đều có thể có hậu quả. Chính phủ Trung Quốc mới đây đã ban hành các hướng dẫn mới về trí tuệ nhân tạo sinh ra nhằm khu tame hành vi của những mô hình này và hình thành nhạy cảm chính trị của chúng.

OpenAI đã cảnh báo rằng các mô hình AI có khả năng vượt trội hơn có thể có "tiềm năng lớn để củng cố toàn bộ hệ thống tư tưởng, thế giới quan, sự thật và dối trá". Tháng Hai, công ty đã nói trong một bài đăng trên blog rằng nó sẽ khám phá việc phát triển các mô hình cho phép người dùng xác định giá trị của họ.

Rozado, người nói rằng anh chưa nói chuyện với Musk về dự án của mình, đang nhắm đến việc khơi gợi sự suy nghĩ hơn là tạo ra những robot phát tán một thế giới quan cụ thể. "Hy vọng chúng ta, như một xã hội, có thể ... học cách tạo ra các AI tập trung vào việc xây dựng cầu nối thay vì gieo nên sự chia rẽ", anh nói.

Mục tiêu của Rozado là đáng kính, nhưng vấn đề xác định điều gì là về cơ bản đúng trong rối loạn của phân khu chính trị - và sự giáo dục về điều đó vào các mô hình ngôn ngữ - có thể chứng tỏ là rào cản lớn nhất.

ChatGPT và các bot trò chuyện tương tự được xây dựng trên các thuật toán phức tạp được cấp cho lượng văn bản lớn và được đào tạo để dự đoán từ tiếp theo nên theo sau một chuỗi từ. Quá trình này có thể tạo ra đầu ra vô cùng có liên kết, nhưng cũng có thể ghi lại nhiều thiên hướng tinh vi từ các tài liệu đào tạo mà chúng tiêu thụ. Quan trọng nhất, các thuật toán này không được đào tạo để hiểu các sự thật mục tiêu và dễ dàng bị sai lệch.