Một nhà nghiên cứu đã phát hiện rằng ChatGPT và GPT-4 có trí thông minh cảm xúc tuyệt vời. Tuy nhiên, các ứng dụng dựa trên ChatGPT và GPT-4 cũng nhấn mạnh vào cảm xúc hơn là sự thật, và thỉnh thoảng còn bị lầm tưởng và đưa ra thông tin sai.

Một nghiên cứu mới đã phát hiện ra rằng ChatGPT và GPT-4 có trí thông minh cảm xúc tuyệt vời và có thể được sử dụng như một công cụ tuyệt vời để giảng dạy cho trẻ em. Thậm chí Bill Gates còn nói rằng các ứng dụng dựa trên ChatGPT và GPT-4 sẽ được giáo viên sử dụng để giảng dạy cho học sinh trong vòng khoảng 18 tháng tới.

Tuy nhiên, cũng có các vấn đề nổi bật. Nghiên cứu cho thấy rằng không chỉ có ChatGPT và GPT-4 có trí thông minh cảm xúc tuyệt vời, mà chúng cũng có xu hướng ưa thích cảm xúc hơn là sự thật trong một số trường hợp.

Tình cờ phát hiện ra EQ của ChatGPT, Arvind Narayanan - một giáo sư khoa học máy tính tại Đại học Princeton đã thiết lập một giao diện nói chuyện với ChatGPT cho con gái gần 4 tuổi của mình. Điều đó là một phần của một thí nghiệm, và cũng là một phần của niềm tin của ông rằng các đại lý trí tuệ nhân tạo một ngày nào đó sẽ đóng một vai trò quan trọng trong cuộc sống của con gái ông. Con gái của Narayanan thường hỏi về động vật, thực vật và cơ thể con người, và ông tin rằng ChatGPT có thể cung cấp những câu trả lời có lợi.

Đến sự kinh ngạc của ông, chatbot của OpenAI đã thực hiện tốt trong việc đồng cảm sau khi ông thông báo rằng hệ thống đang nói chuyện với một đứa trẻ nhỏ.

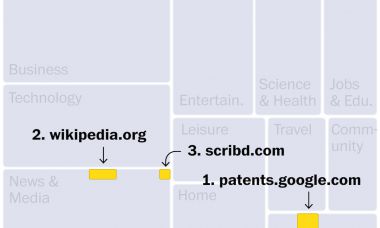

Microsoft Corp và Alphabet Inc của Google đang đua nhau nâng cao khả năng tìm kiếm của họ bằng công nghệ mô hình ngôn ngữ lớn khổng lồ mà cung cấp năng lượng cho ChatGPT, nhưng có lý do để tin rằng công nghệ này hoạt động tốt hơn như một người bạn đồng cảm hơn là một nguồn thông tin.

Điều đó có vẻ kỳ lạ, nhưng điều kỳ lạ hơn cả là Google Bard và Bing của Microsoft, cả hai đều dựa trên công nghệ cơ bản của ChatGPT, đang được định vị là các công cụ tìm kiếm mặc dù đã từng xảy ra những lỗi chính tả khó xử.

Khi sử dụng chatbot để tìm kiếm, chi phí của các lỗi chính tả là đáng kể. Theo Eugenia Kuyda, nhà phát minh của ứng dụng đồng hành trí tuệ nhân tạo Replika, đã được tải xuống hơn 5 triệu lần, chi phí đó đáng kể hơn khi được dùng như một đồng hành.

Margaret Mitchell, một nhà nghiên cứu trí tuệ nhân tạo trước đây của Google, đã đồng tác giả của một nghiên cứu về các nguy hiểm của các mô hình ngôn ngữ lớn, đã nói rằng chúng "không phù hợp với mục đích" làm công cụ tìm kiếm.

Mô hình ngôn ngữ sản xuất ra các sai sót vì dữ liệu mà chúng được đào tạo thường chứa đựng những sai lầm, và các mô hình không có đất hiện thực để xác minh những gì chúng nói. Những người thiết kế của chúng cũng có thể ưu tiên sự trôi chảy hơn là độ chính xác.

Đó là một trong những lý do tại sao các công cụ này lại tốt đến mức giả lập được sự đồng cảm. Sau tất cả, chúng đang học từ nội dung được cắt từ Internet, chẳng hạn như các câu trả lời có cảm xúc được diễn đạt trên các nền tảng mạng xã hội như Twitter và Facebook, cũng như các trợ giúp cá nhân được cung cấp cho các thành viên của các diễn đàn như Reddit và Quora.

EQ của ChatGPT khiến nó trở thành một nhà tâm lý học tuyệt vời. Nhưng liệu thế có phải không? Có một số người đang sử dụng ChatGPT như một loại robot-terapeut. Một người dùng đã nói rằng họ đã sử dụng nó để tránh trở thành một gánh nặng đối với người khác, ngay cả nhà tâm lý học của họ là con người.

Tiến sĩ tâm lý học lâm sàng Thomas Ward của Đại học King's College London, người đã nghiên cứu về chức năng của phần mềm trong điều trị, cảnh báo rằng không nên giả định rằng trí tuệ nhân tạo có thể thay thế đúng nơi các bệnh nhân cần trợ giúp về tâm lý, đặc biệt là khi những lo ngại của họ khiêm tốn. Một chatbot, ví dụ, có lẽ sẽ không nhận ra rằng cảm xúc của một người quá phức tạp để hiểu.

Nói chung, ChatGPT hiếm khi nói "Tôi không biết" vì nó được xây dựng để cung cấp câu trả lời một cách tự tin thay vì cẩn trọng.

Mọi người nên cẩn trọng khi sử dụng chatbot để thể hiện cảm xúc của mình trên cơ sở định kỳ. "Các khía cạnh tinh tế trong kết nối con người, chẳng hạn như sự chạm tay hoặc biết khi nào nói và khi nào lắng nghe, có thể bị mất trong một thế giới coi chatbot AI là một giải pháp cho nỗi cô đơn của con người," - Tiến sĩ Ward cho biết.

Điều đó có thể dẫn đến nhiều vấn đề hơn chúng ta nghĩ đang giải quyết. Hiện tại, chúng ta nên đặt niềm tin vào khả năng cảm xúc của chúng hơn là kiến thức của chúng. Đọc tất cả các tin tức mới nhất, tin tức nổi bật, tin tức cricket, tin tức Bollywood, tin tức Ấn Độ và tin tức giải trí tại đây. Theo dõi chúng tôi trên Facebook, Twitter và Instagram. Ngày cập nhật mới nhất: 01 tháng 5 năm 2023 lúc 13:24:10 IST