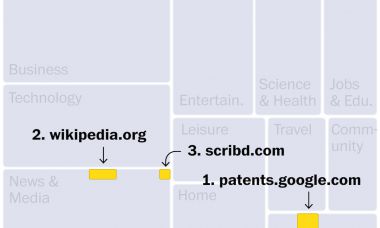

Các trợ lý ảo được trang bị trí tuệ nhân tạo như ChatGPT và Google Bard đang là trung tâm chú ý của giới công nghệ. Thế hệ công cụ phần mềm trò chuyện mới này hứa hẹn có thể thay thế quy trình tìm kiếm web và sản xuất vô vàn tác phẩm văn học sáng tạo và nhớ tất cả kiến thức của thế giới để rải vào các ứng dụng. ChatGPT, Google Bard và các trợ lý ảo khác giống chúng được xây dựng trên mô hình ngôn ngữ lớn, hay LLMs, và cần phải tìm hiểu cách chúng hoạt động để sử dụng tốt hơn và hiểu rõ những gì chúng giỏi (và những gì chúng không đáng tin cậy). Tương tự như nhiều hệ thống trí tuệ nhân tạo khác, như các hệ thống được thiết kế để nhận dạng giọng nói của bạn hoặc tạo ra hình ảnh mèo, LLMs được đào tạo với lượng dữ liệu khổng lồ. Các công ty đứng sau chúng đã khá thận trọng khi tiết lộ chính xác chúng đến từ đâu, nhưng có những manh mối chúng ta có thể nhìn vào. Chẳng hạn, bài báo nghiên cứu giới thiệu mô hình LaMDA (Language Model for Dialogue Applications) mà Bard được xây dựng trên đề cập Wikipedia, "diễn đàn công cộng," và "tài liệu về mã nguồn từ các trang liên quan đến lập trình như Q&A sites, hướng dẫn, vv." Trong khi đó, Reddit muốn bắt đầu tính phí cho việc truy cập vào 18 năm cuộc trò chuyện văn bản của mình, và StackOverflow chỉ mới tuyên bố kế hoạch tính phí. Ngụ ý ở đây là LLMs đã sử dụng cả hai trang web này rộng rãi cho đến điểm này như các nguồn tiếp cận, hoàn toàn miễn phí và trên sự ủng hộ của những người đã xây dựng và sử dụng các nguồn tài nguyên đó. Rõ ràng là một phần lớn những gì được công khai trên web đã được đánh cắp và phân tích bởi LLMs.

LLMs sử dụng kết hợp giữa học máy và đầu vào của con người. Tất cả dữ liệu văn bản này, bất kể nó đến từ đâu, được xử lý thông qua một mạng thần kinh, loại động cơ trí tuệ nhân tạo phổ biến được tạo thành từ nhiều nút và lớp. Những mạng này liên tục điều chỉnh cách chúng hiểu và hiểu được dữ liệu dựa trên rất nhiều yếu tố, bao gồm kết quả từ các thử nghiệm trước đó. Hầu hết LLMs sử dụng một kiến trúc mạng thần kinh cụ thể được gọi là transformer, có một số thủ thuật đặc biệt phù hợp cho xử lý ngôn ngữ. (GPT sau Chat viết tắt của Generative Pretrained Transformer.) Cụ thể, một transformer có thể đọc rất nhiều văn bản, tìm ra các mẫu trong cách từ và cụm từ liên quan đến nhau, và sau đó dự đoán những từ nên xuất hiện tiếp theo. Bạn có thể đã từng nghe về LLMs được so sánh với các động cơ tự động sửa lỗi văn bản, và thực tế đó không quá xa vời: ChatGPT và Bard không thực sự "biết" gì cả, nhưng chúng rất giỏi at việc tìm ra từ nào sẽ tiếp theo, điều này bắt đầu trông giống như suy nghĩ thực sự và sáng tạo khi nó đạt đến một giai đoạn đủ tiên tiến. Một trong những đột phá chính của những chiếc transformer này là cơ chế tự chú ý. Khó giải thích chỉ trong một đoạn văn, nhưng đơn giản là nghĩa của các từ trong một câu không được xem xét đơn lẻ, mà còn liên quan đến nhau theo nhiều cách tinh vi khác nhau. Nó cho phép có một mức độ hiểu biết sâu hơn so với những gì khả thi nếu không có. Có một số tính ngẫu nhiên và biến đổi được tích hợp vào code, đó là lý do tại sao bạn sẽ không nhận được phản hồi giống nhau từ một Chatbot transformer mỗi lần. Ý tưởng sửa lỗi này cũng giải thích tại sao sai sót có thể xảy ra. Ở mức cơ bản, ChatGPT và Google Bard không biết điều gì là chính xác và điều gì không. Chúng đang tìm kiếm các câu trả lời có vẻ hợp lý và tự nhiên, và phù hợp với dữ liệu của chúng đã được đào tạo.